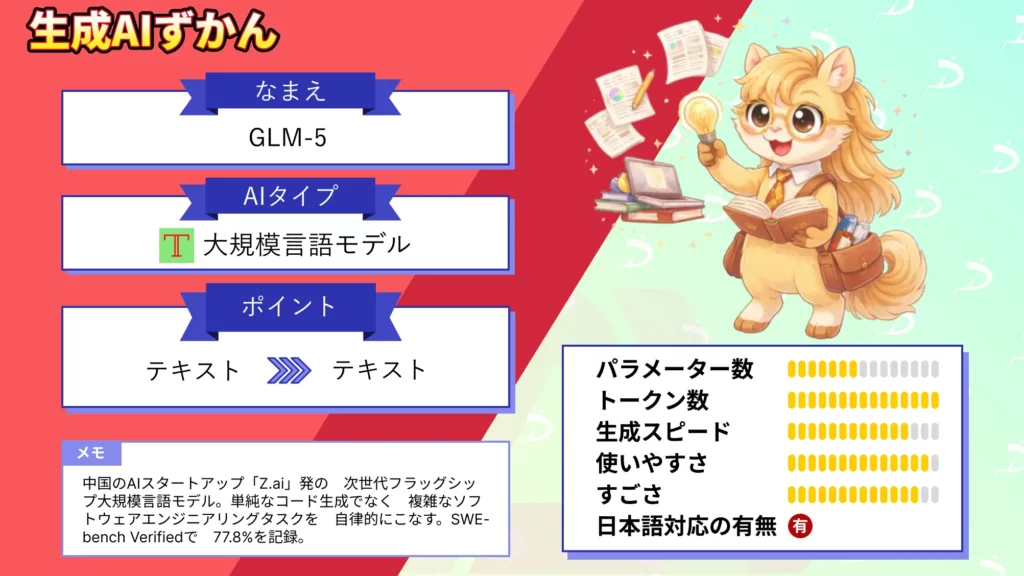

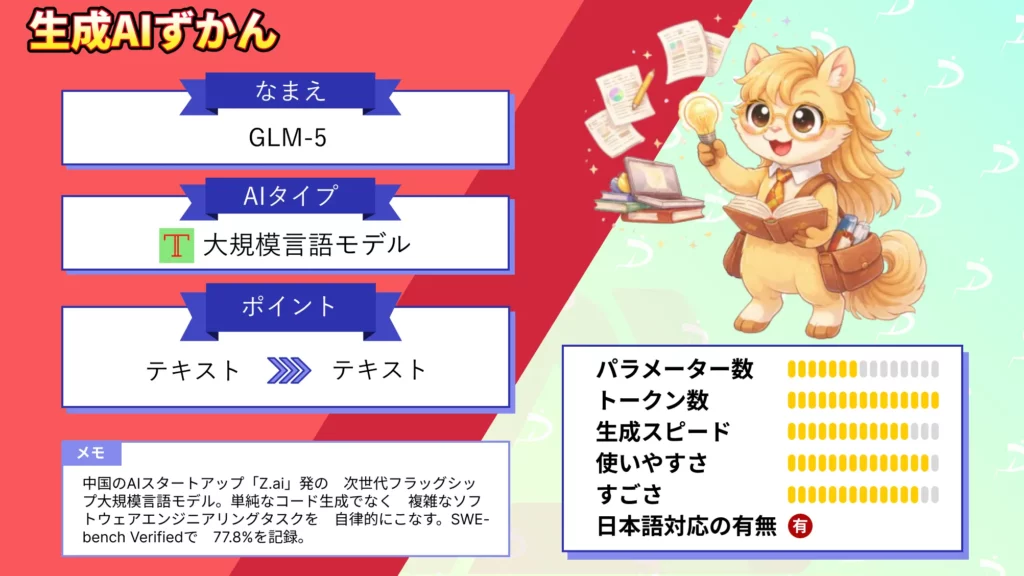

- 中国のAIスタートアップ「Z.ai」発の次世代フラッグシップ大規模言語モデル

- 単純なコード生成でなく、複雑なソフトウェアエンジニアリングタスクを、自律的にこなす

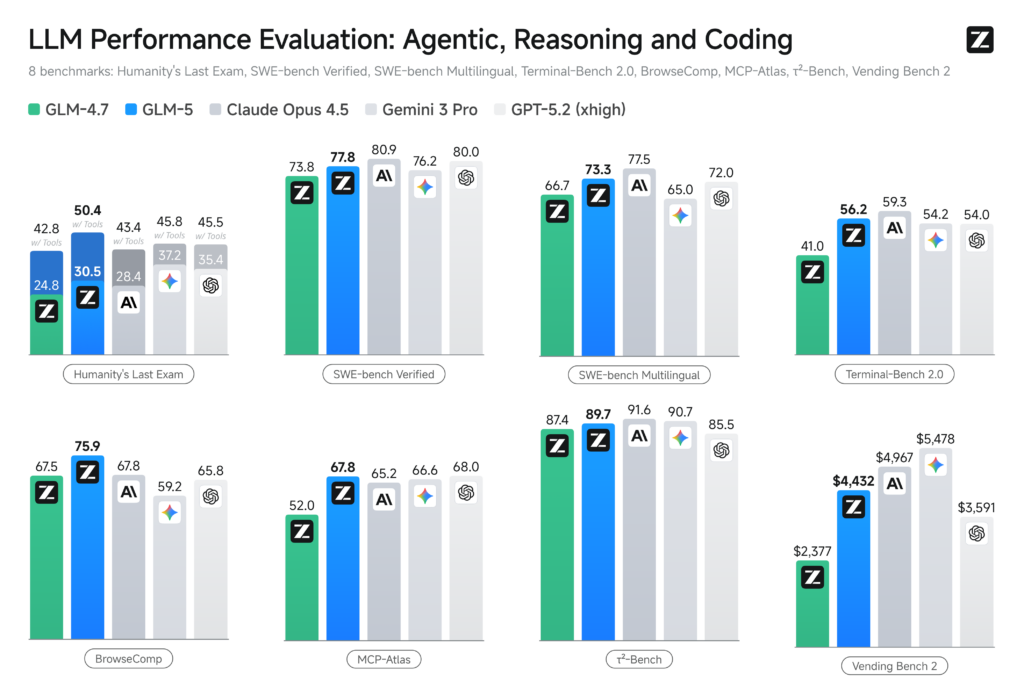

- SWE-bench Verifiedで77.8%を記録し、Claude Opus 4.5の80.9%に対してその差は約3ポイントまで迫る

2026年2月12日、中国のAIスタートアップであるZ.aiが、第5世代の大規模言語モデル「GLM-5」を正式にリリースしました!

GLM-5の総パラメータ数は約745億(744B)、推論時のアクティブパラメータは約40Bという巨大なMixture of Experts(MoE)アーキテクチャを採用し、コーディングとエージェント能力においてオープンソースモデルのSOTA(最高水準)を達成しているそうです。

また、Claude Opus 4.5に迫るベンチマークスコアを叩き出しながら、MITライセンスでオープンウェイト公開が予定されているという点が、業界内に大きなインパクトを与えています。

そこで本記事では、このGLM-5の概要や仕組み、料金情報や使い方まで、徹底的に解説します。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

GLM-5の概要

GLM-5は、Z.ai(旧Zhipu AI)が開発した次世代フラッグシップモデルです。

清華大学のスピンオフとして2019年に設立された同社は、2025年にZ.aiへリブランドし、2026年1月には香港証券取引所に上場を果たしています。今回のGLM-5は、その上場で調達した約4.35億香港ドル(約558億円)の資金を背景に、開発が加速されたモデルだそうです。

最大の特徴は、従来の「コードを書くAI」から「システムを構築するAI」へ転換を掲げている点にあります。

Z.aiもこれを「Agentic Engineering」と呼んでいて、単純なコード生成ではなく、リポジトリの探索・ビルドのデバッグ・システムリファクタリングといった複雑なソフトウェアエンジニアリングタスクを、最小限の人間の介入で自律的にこなすことを目指しています。

GLM-5は、Claude CodeやRoo Code、Cline、Kilo Codeなど10種類以上のコーディングツールとの互換性を持ち、OpenRouterからも利用可能です。

公式チャット「chat.z.ai」では無料でチャットモードとエージェントモードを試すこともできます。さらに、.docxや.pdf、.xlsxファイルを直接生成する機能も備えており、コーディングだけでなく事務処理の自動化にも対応しています。

なお、Claudeでお馴染みのAnthoropic社の自立型エージェントについて、詳しく知りたい方は以下の記事も参考にしてみてください。

GLM-5の仕組み

GLM-5のアーキテクチャは、Mixture of Experts(MoE)方式を基盤としています。

総パラメータ数は約745B(7450億)で、256個のエキスパートモジュールのうち、1トークンあたり8個のエキスパートだけがアクティベートされます(スパース率5.9%)。これによって、推論時に実際に動くパラメータは約40Bに抑えられ、巨大モデルの精度を維持しながら計算コストを大幅に削減する設計です。

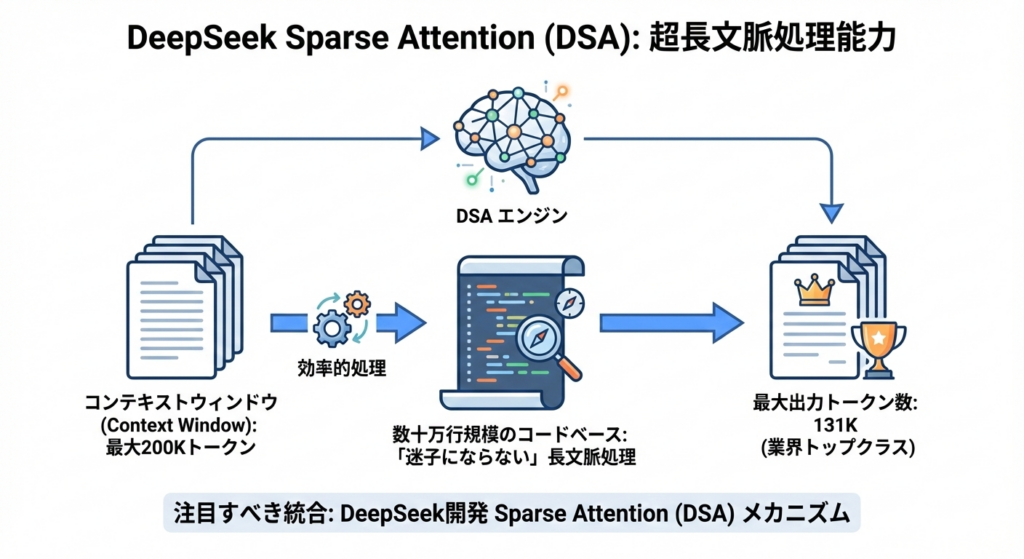

注目すべきは、DeepSeekが開発したSparse Attention(DSA)メカニズムを統合している点です。

これによって、最大200Kトークンのコンテキストウィンドウを効率的に処理でき、数十万行規模のコードベースでも「迷子にならない」長文脈処理を実現しています。最大出力トークン数は131Kで、これは業界トップクラスの値です。

学習には28.5兆トークンのデータセットが使われ、前世代のGLM-4.5(23兆トークン)から大幅に拡張されました。

ポストトレーニングには「Slime」と呼ばれる独自の非同期強化学習(Asynchronous RL)フレームワークが採用されています。

GLM-5の特徴

GLM-5の特徴の1つとして、主要ベンチマークにおけるスコアがあります。公式が公表している数値をみると、オープンソースモデルとして世界最高水準に到達していることがわかります。

SWE-bench Verified(実際のGitHub issueを解決するソフトウェアエンジニアリングベンチマーク)では77.8%を記録しています。参考までに、Claude Opus 4.5が80.9%ですので、その差は約3ポイントまで縮まっています。

Terminal-Bench 2.0(ターミナル環境での複雑なタスク実行を評価するベンチマーク)では56.2%を達成し、オープンソースモデルのなかで首位です。さらに、Humanity’s Last Exam(ツール使用時)では50.4点を記録し、これはClaude Opus 4.5、Gemini 3 Pro、GPT-5.2を上回るスコアとなっています。

また、長期タスクの安定性を測るVending Bench 2(1年間の自動販売機運営をシミュレーションするベンチマーク)では4,432ドルの残高を達成し、こちらもオープンソースモデル全体で1位となっています。BrowseComp(ウェブ検索を伴う複雑な質問応答ベンチマーク)でも75.9を記録し、テストされた全モデルのなかで最高スコアでした。

CC-Bench-V2(フロントエンド開発ベンチマーク)では、ビルド成功率98%、エンドツーエンドの正確性74.8%を叩き出しており、前世代のGLM-4.7から26ポイントもの改善が見られます。

推論速度は17~19トークン/秒で、GPT-5.2やClaude Opus 4.5の25~30トークン/秒には及びませんが、オープンソースモデルとしては十分実用的な水準だと思います。

なお、前世代のGLM-4.7について、詳しく知りたい方は以下の記事も参考にしてみてください。

GLM-5の安全性・制約

GLM-5のサービスはシンガポールを拠点に運営されており、Z.aiの公式情報によれば、ユーザーのテキストプロンプト・画像・入力データはいずれもサーバーに保存されない方針です。

ただし、注意すべき点もあります。

Z.aiは、米国のEntity List(エンティティリスト)に掲載されていて、米国の制裁対象企業です。そのため、利用にあたっては各地域の輸出管理規制やコンプライアンス要件を確認する必要もあります。

また、GLM-5の英語圏でのパフォーマンス評価は、まだ独立ベンチマークが十分に出揃っていない段階であり、中国語タスクでの性能が相対的に高い可能性がある点にも留意が必要です。

GLM-5の料金

GLM-5のAPI料金は、フロンティアモデルのなかでは非常にリーズナブルな水準に設定されています。

GPT-5.2の入力料金($1.75/100万トークン)やClaude Opus 4.6の料金と比較すると、大幅にコストを抑えられる構成です。

特に、キャッシュ入力の料金が$0.2と安いため、エージェント型ワークフローのように大量のコンテキストを繰り返し参照するユースケースでは、さらにコスト効率が高まるかと思います。

| モデル | 入力 | キャッシュ入力 | 出力 |

|---|---|---|---|

| GLM-5 | 1ドル | 0.2ドル | 3.2ドル |

| GLM-5-Code | 1.2ドル | 0.3ドル | 5ドル |

| GLM-4.7(参考) | 0.6ドル | 0.11ドル | 2.2ドル |

| プラン | 月額料金 | GLM-5対応 |

|---|---|---|

| Liteプラン | 6ドル(初月3ドル) | ※非対応(今後対応予定) |

| Proプラン | 30ドル(初月15ドル) | ※非対応(今後対応予定) |

| Maxプラン | 非公開 | 対応済み |

※2026年2月12日時点

なお、Claude Opus 4.6について、詳しく知りたい方は以下の記事も参考にしてみてください。

GLM-5のライセンス

GLM-5は、Z.aiのオープンソース戦略を継承する形でリリースされています。

前世代のGLM-4.7やGLM-4.5が、MITライセンスでHugging Faceに公開されてきた実績があり、GLM-5もMITライセンスでのオープンウェイト公開が予定されています(2026年2月12日時点でHugging Faceにモデルウェイトが公開済みとの情報あり)。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 |  | |

| 改変 |  | |

| 配布 |  | |

| 特許使用 |  | MITライセンスの範囲内で可能 |

| 私的使用 |  |

GLM-5の使い方

GLM-5には複数のアクセス方法が用意されています。ここでは主要な3つの使い方をご紹介します。

公式チャット(chat.z.ai)でブラウザから使う

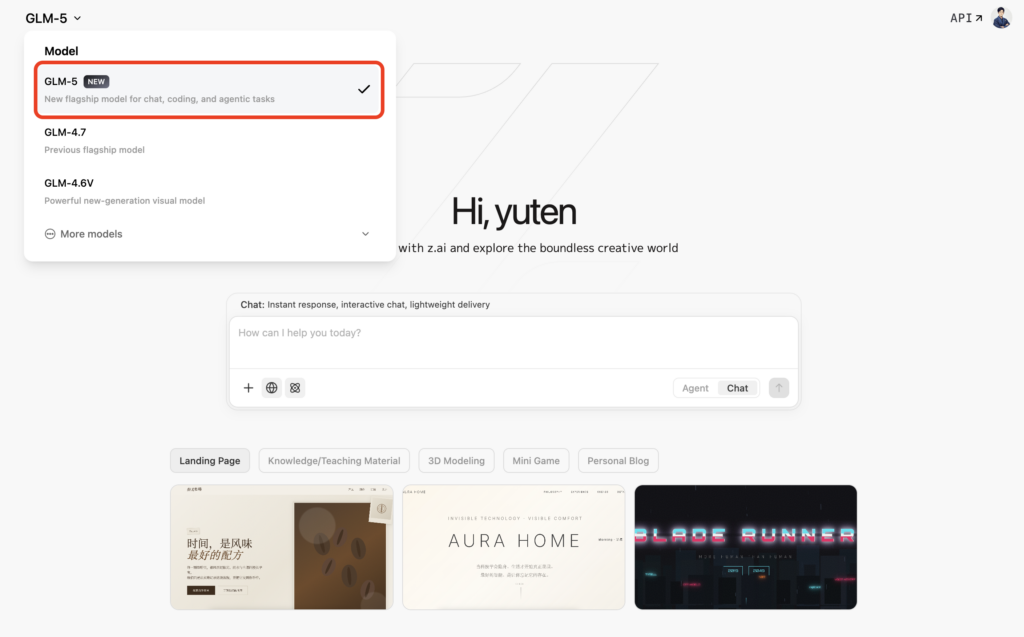

まずブラウザで https://chat.z.ai/ にアクセスし、アカウントを作成するか、既存アカウントでログインします。

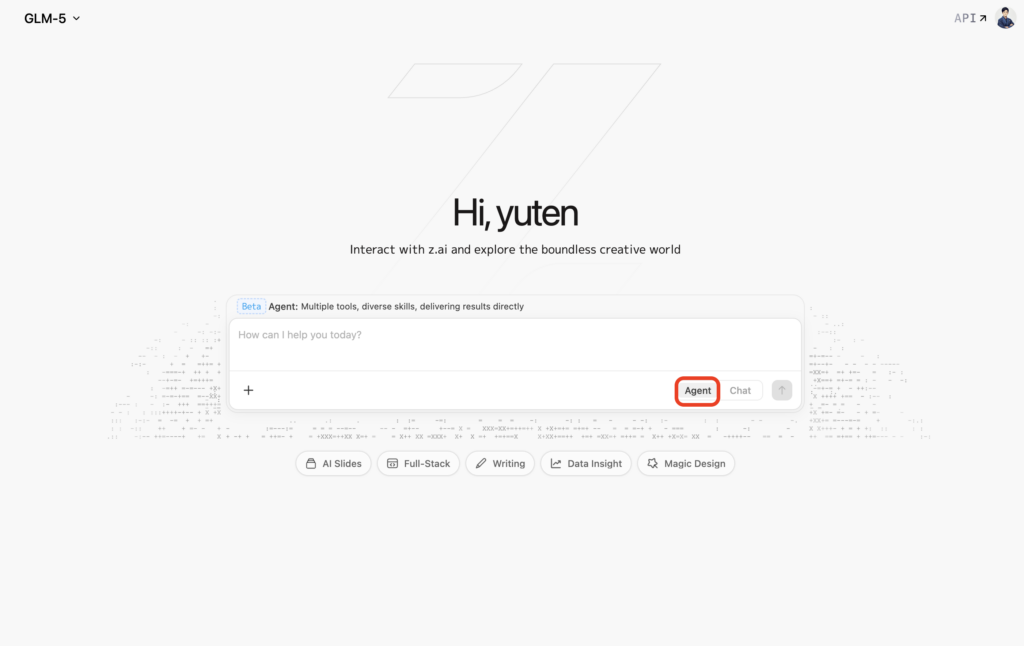

画面左上のモデル選択ドロップダウンから「GLM-5」を選択します。チャット欄にプロンプトを入力するだけで、GLM-5とのやり取りをスタートできます。

チャットモードの他にも「Agent」モードが搭載されていて、こちらではデータ分析やドキュメント生成などの高度なタスクを自動実行してくれます。

Claude Code(CLI)経由で使う

Z.aiのサブスクリプションページ(https://z.ai/subscribe)にアクセスし、GLM Coding Planに加入します。GLM-5を使いたい場合は、2026年2月12日時点ではMaxプランのみが選択肢になっています。

Z.aiのダッシュボードからAPIキーを取得し、Claude Codeの設定ファイルを編集します。

// ~/.claude/settings.json

{

"apiProvider": "zai",

"model": "GLM-5",

"apiKey": "your-zai-api-key"

}ターミナルでClaude Codeを起動すると、GLM-5がバックエンドモデルとして使用されます。

claudeこれで、ターミナルから直接GLM-5にコーディングタスクを依頼できるようになります。

APIで呼び出す(開発者向け)

https://docs.z.ai/ にアクセスし、デベロッパーアカウントを作成し、ダッシュボードからAPIキーを発行します。

OpenAI互換のエンドポイント形式でAPIコールを行います。

import requests

url = "https://api.z.ai/v4/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": "Bearer YOUR_API_KEY"

}

data = {

"model": "glm-5",

"messages": [

{"role": "user", "content": "Pythonで交通信号シミュレーションを作成してください"}

],

"max_tokens": 4096,

"temperature": 0.7

}

response = requests.post(url, headers=headers, json=data)

print(response.json())レスポンスのJSON内の choices[0].message.content にGLM-5の出力が格納されます。

なお、OpenRouterやWaveSpeed API経由でもGLM-5にアクセス可能となっています。さらに、vLLMやSGLangなどの推論フレームワークに対応しているため、Hugging Faceからモデルウェイトをダウンロードしてローカル環境にデプロイすることも可能です。

【業界別】GLM-5の活用シーン

GLM-5は、その強力なコーディング能力とエージェント機能を活かして、幅広い業界で活用が期待できます。

IT業界

ソフトウェア開発においては、バックエンドのリファクタリングや頑固なバグの修正といった「システムレベルの開発タスク」に特に威力を発揮します。また、SIerやWeb制作会社では、フルスタック開発の生産性向上ツールとして導入が見込めるかと思います。

金融業界

金融業界においては、データ分析レポートの自動生成(.xlsxファイルの直接出力対応)や、複雑なアルゴリズムの実装支援に活用することができるかと思います。

なお、金融業界における生成AI活用事例について、詳しく知りたい方は以下の記事も参考にしてみてください。

教育業界

研究・学術分野では、200Kトークンのコンテキストウィンドウを活かし、論文の横断的な分析や大規模コードベースの解析に適しています。

なお、教育業界における生成AI活用について、詳しく知りたい方は以下の記事も参考にしてみてください。

製造業界

製造業では、エージェントモードを活用した提案書やWord文書の自動作成が、事務工数の削減に直結する可能性があります。

なお、製造業界における生成AI活用事例について、詳しく知りたい方は以下の記事も参考にしてみてください。

【課題別】GLM-5が解決できること

リファクタリング工数削減

「大規模なレガシーコードのリファクタリングに工数がかかりすぎる」といった課題には、GLM-5のシステムエンジニアリング能力が活かされると思います。

200Kトークンのコンテキストでリポジトリ全体を把握しながら、的確な修正パッチを生成できるかと思います。

なお、生成AIによるシステム開発について、詳しく知りたい方は以下の記事も参考にしてみてください。

従来エージェントツール利用料金の削減

「Claude MaxやGPT-5のAPI料金が高すぎてチームに展開できない」といった課題には、GLM-5の圧倒的なコスト効率が解決策となります。

入力$1/100万トークンという価格帯は、GPT-5.2の入力料金の約半分となっています。

GLM-5を使ってみた

それでは実際に、公式チャット(chat.z.ai)でGLM-5を試してみます!

プロンプトはこちら

Pythonで一方通行の道路における交通信号の動作原理を視覚的にシミュレーションしてください。車両はランダムな速度で進入します。生成されたコードはこちら

import matplotlib.pyplot as plt

import matplotlib.patches as patches

import matplotlib.animation as animation

import random

import numpy as np

# --- 設定パラメータ ---

ROAD_LENGTH = 100

ROAD_WIDTH = 10

LIGHT_POS = 70

CAR_LENGTH = 4

CAR_WIDTH = 2

SPAWN_RATE = 0.04

SAFE_DIST = 5

# 信号の時間設定 (フレーム数)

GREEN_TIME = 60

YELLOW_TIME = 20

RED_TIME = 50

class Car:

def __init__(self, x, speed, color):

self.x = x

self.speed = speed

self.color = color

self.current_speed = speed

def move(self):

self.x += self.current_speed

class TrafficLight:

def __init__(self, pos):

self.pos = pos

self.state = 'GREEN'

self.timer = 0

def update(self):

self.timer += 1

if self.state == 'GREEN' and self.timer >= GREEN_TIME:

self.state = 'YELLOW'

self.timer = 0

elif self.state == 'YELLOW' and self.timer >= YELLOW_TIME:

self.state = 'RED'

self.timer = 0

elif self.state == 'RED' and self.timer >= RED_TIME:

self.state = 'GREEN'

self.timer = 0

def get_color(self):

if self.state == 'GREEN': return 'green'

if self.state == 'YELLOW': return 'yellow'

if self.state == 'RED': return 'red'

# --- シミュレーション実行 ---

cars = []

light = TrafficLight(LIGHT_POS)

fig, ax = plt.subplots(figsize=(10, 3))

def init():

ax.set_xlim(-5, ROAD_LENGTH + 5)

ax.set_ylim(-ROAD_WIDTH/2 - 2, ROAD_WIDTH/2 + 6)

ax.set_aspect('equal')

return []

def animate(frame):

ax.clear()

ax.set_xlim(-5, ROAD_LENGTH + 5)

ax.set_ylim(-ROAD_WIDTH/2 - 2, ROAD_WIDTH/2 + 6)

ax.axis('off')

# 道路

road = patches.Rectangle((-5, -ROAD_WIDTH/2), ROAD_LENGTH + 10, ROAD_WIDTH, fc='gray', ec='black')

ax.add_patch(road)

# 停止線

stop_line = patches.Rectangle((LIGHT_POS - 1, -ROAD_WIDTH/2), 0.5, ROAD_WIDTH, fc='white')

ax.add_patch(stop_line)

# 信号機更新

light.update()

ax.plot([light.pos, light.pos], [ROAD_WIDTH/2, ROAD_WIDTH/2 + 3], color='black', lw=3)

light_circle = plt.Circle((light.pos, ROAD_WIDTH/2 + 3.5), 1.2, color=light.get_color())

ax.add_patch(light_circle)

# 車生成

if random.random() < SPAWN_RATE:

if not any(car.x < CAR_LENGTH + 2 for car in cars):

initial_speed = random.uniform(0.5, 1.2)

car_color = (random.random(), random.random(), random.random())

new_car = Car(-CAR_LENGTH, initial_speed, car_color)

cars.append(new_car)

# 車の挙動更新

cars.sort(key=lambda c: c.x)

for i, car in enumerate(cars):

front_car_dist = float('inf')

if i < len(cars) - 1:

front_car = cars[i+1]

front_car_dist = front_car.x - (car.x + CAR_LENGTH)

light_dist = float('inf')

should_stop_at_light = False

if car.x + CAR_LENGTH < light.pos:

light_dist = light.pos - (car.x + CAR_LENGTH)

if light.state == 'RED':

should_stop_at_light = True

elif light.state == 'YELLOW':

should_stop_at_light = True

obstacle_dist = min(front_car_dist, light_dist)

if (should_stop_at_light and light_dist < 20) or front_car_dist < SAFE_DIST + 5:

if obstacle_dist < SAFE_DIST:

car.current_speed = 0

else:

car.current_speed = max(0, car.speed * (obstacle_dist / 20))

else:

car.current_speed = min(car.speed, car.current_speed + 0.05)

car.move()

# 画面外削除

cars[:] = [car for car in cars if car.x < ROAD_LENGTH + 10]

# 車描画

for car in cars:

body = patches.Rectangle((car.x, -CAR_WIDTH/2), CAR_LENGTH, CAR_WIDTH, fc=car.color, ec='black')

ax.add_patch(body)

ax.set_title(f"Frame: {frame} | Signal: {light.state}", fontsize=10)

return []

# GIF生成用設定

anim = animation.FuncAnimation(fig, animate, init_func=init, frames=200, interval=50, blit=False)

# GIFとして保存

output_path = "/mnt/data/traffic_simulation.gif"

anim.save(output_path, writer='pillow', fps=20)

plt.close()

print(f"GIFを生成しました: {output_path}")生成されたアニメーションはこちら

2〜3分ほどでコードを生成してくれましたが、アニメーションは自然に表現できていて良い感じです。日本語プロンプトで入力しましたが、意味や意図を問題なく汲み取ってくれています。

プロンプトはこちら

HTML + CSS + JavaScriptで、地球周回衛星がドップラー効果の信号を送信する様子をアニメーション付きで可視化してください出力結果はこちら

よくある質問

まとめ

GLM-5は、Z.aiが送り出した第5世代のフラッグシップモデルであり、オープンソースLLMの新たな到達点です。

コスト面でも、GPT-5.2やClaude Opus 4.6と比較して大幅に安い料金設定が魅力で、特に「フロンティア級の性能が欲しいが、API費用やベンダーロックインがネック」といった開発者の方やチームにとっては、非常に有力な選択肢になるかと思います。

公式チャットページからすぐに無料で試せますので、まずはその実力をご自身で確かめてみてください。

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。