- OpenAI×Cerebrasが生んだリアルタイムコーディングAI

- 秒速1,000トークン超という圧倒的な生成速度を実現

- 2026年2月13日時点で、リサーチプレビューとして公開、ChatGPT Proユーザーが対象

「コーディングAIの応答が遅くて、思考の流れが途切れてしまう」「AIが長時間タスクに向いているのはわかるけど、ちょっとした修正にも何十秒も待つのはつらい」「リアルタイムでAIとペアプログラミングできたら……」。こうした悩みを抱えている開発者の方は、少なくないのではないでしょうか。

2026年2月13日、OpenAIはこうした課題に正面から応える新モデル「GPT-5.3-Codex-Spark」を発表しました!

GPT-5.3-Codex-Sparkは、Cerebras社のウェハースケールチップ上で動作し、秒速1,000トークン超という圧倒的な生成速度を実現した、リアルタイムコーディングに特化した初めてのモデルです。

本記事では、このGPT-5.3-Codex-Sparkの概要から仕組み、料金体系、具体的な使い方まで、徹底解説していきます。

ぜひ最後までご覧ください!

\生成AIを活用して業務プロセスを自動化/

GPT-5.3-Codex-Sparkとは?

GPT-5.3-Codex-Sparkは、2026年2月5日にリリースされたGPT-5.3-Codexの軽量版(小型モデル)として位置づけられています。

GPT-5.3-Codexが数時間から数日にわたるような大規模なコーディングタスクを自律的にこなすことを得意とするのに対し、Codex-Sparkは「瞬時のフィードバック」を最優先に設計されたモデルです。

OpenAIの公式ブログによれば、Codex-Sparkは同社にとって「リアルタイムコーディング向けに設計した初のモデル」であり、2026年1月に発表されたCerebras社との提携における最初のマイルストーンとなっています。

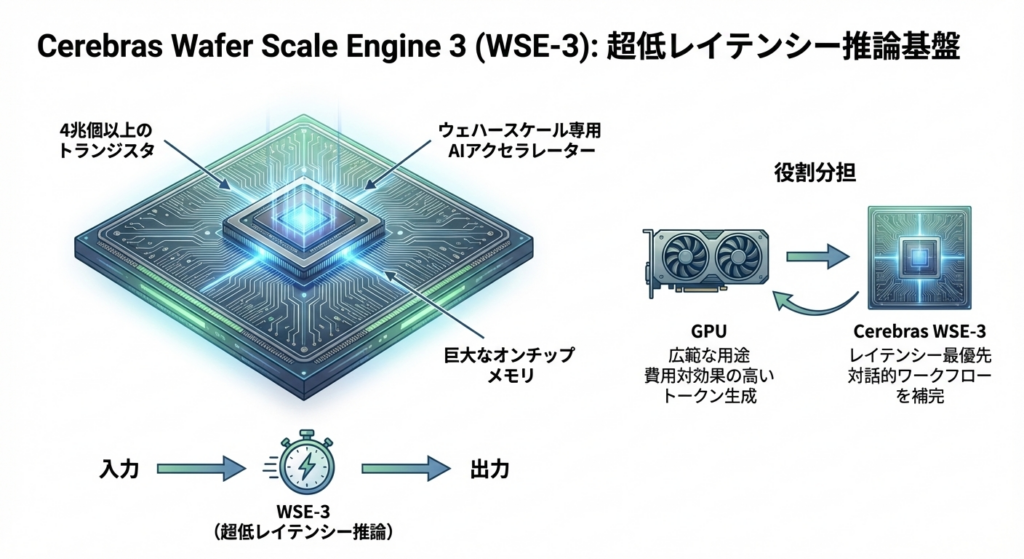

推論処理には、CerebrasのWafer Scale Engine 3(WSE-3)が使われていて、NVIDIA GPU中心だったOpenAIの推論基盤に新たなレイテンシー特化の層が加わった格好となっています。

2026年2月13日時点では、リサーチプレビューとして公開されていて、ChatGPT Proユーザーを対象にCodexアプリ、CLI(コマンドラインインターフェース)、VS Code拡張機能から利用できます。また、一部のAPIデザインパートナーにも早期アクセスが提供されているようです。

128Kトークンのコンテキストウィンドウを備えていますが、テキスト入力のみ対応で、マルチモーダルには未対応です。

なお、GPT-5.3-Codexについて詳しく知りたい方は、以下の記事も参考にしてみてください。

GPT-5.3-Codex-Sparkの仕組み

GPT-5.3-Codex-Sparkのアーキテクチャは、モデル側とインフラ側の両面から最適化が施されています。

モデルそのものは、GPT-5.3-Codexを蒸留・軽量化した小型モデルです。

精度を大きく犠牲にせず、推論速度を最大化するチューニングが行われています。とくにコーディングタスクに特化していて、ピンポイントの編集やロジックの書き換え、インターフェースの調整といった「小回りの利く作業」を素早く処理できるよう設計されています。

推論基盤には、Cerebras社のWafer Scale Engine 3(WSE-3)が採用されています。

WSE-3は、4兆個以上のトランジスタを搭載したウェハースケールの専用AIアクセラレーターで、巨大なオンチップメモリを活かした超低レイテンシー推論を実現します。

GPUが広範な用途で費用対効果の高いトークン生成を担う一方、Cerebrasチップはレイテンシーが最優先される対話的ワークフローを補完する役割を果たします。

GPT-5.3-Codex-Sparkの特徴

GPT-5.3-Codex-Sparkの最大の特徴は、なんといってもその速度です。秒速1,000トークン以上の生成速度により、従来のCodexモデルでは30秒かかっていたタスクが、約2秒で完了するケースも報告されています。

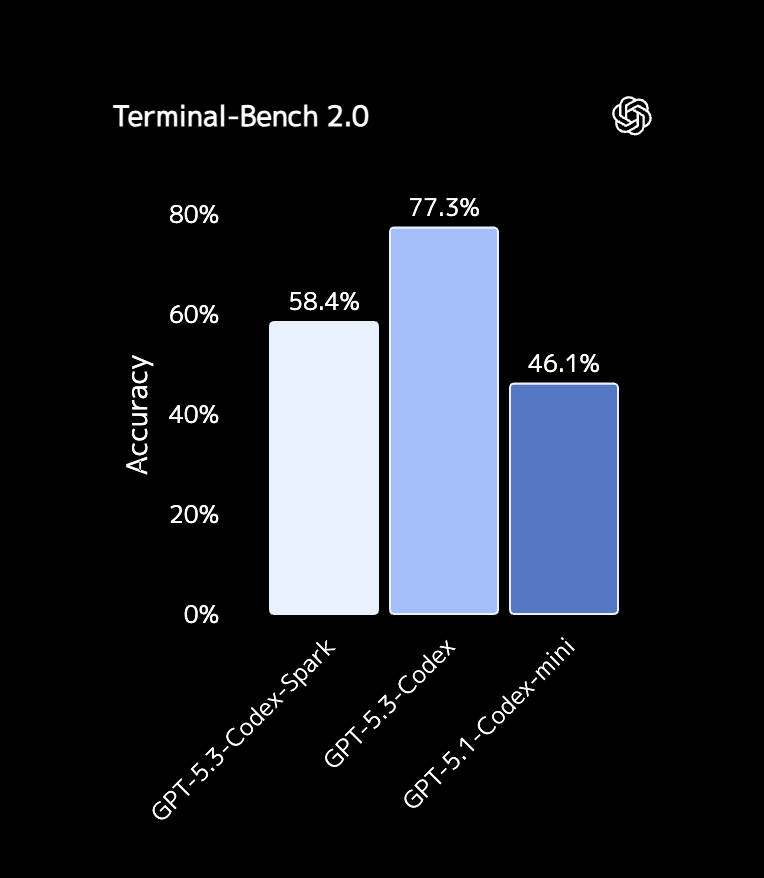

ベンチマーク面では、エージェント型ソフトウェアエンジニアリングの評価指標であるTerminal-Bench 2.0で58.4%のスコアを記録しています。

GPT-5.3-Codex(77.3%)には及びませんが、先代のGPT-5.1-Codex-mini(46.1%)を大きく上回っていて、小型モデルとして十分な実力を備えています。

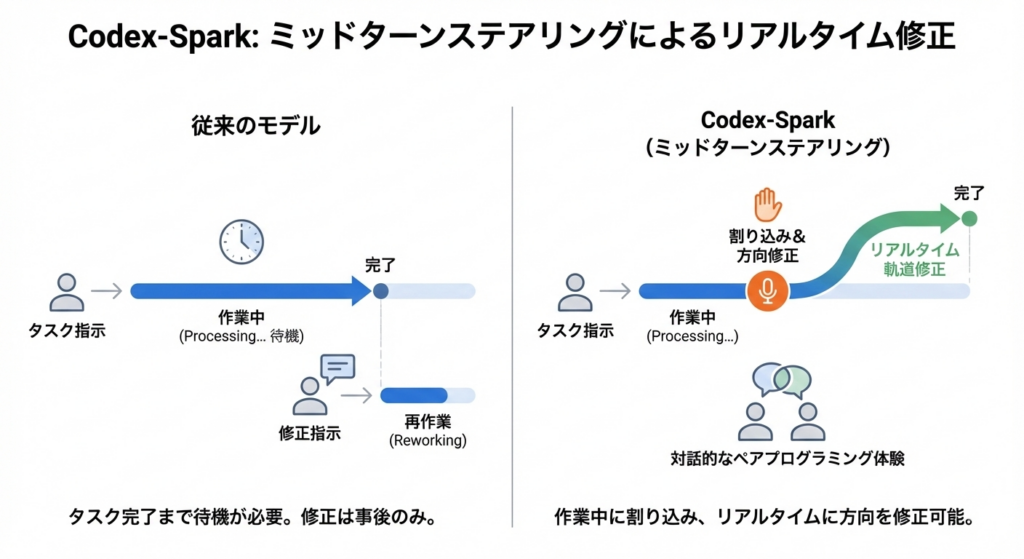

もう1つ注目すべきは「ミッドターンステアリング」に対応している点です。モデルが作業中でも途中で割り込み、方向を修正することができます。

従来のモデルでは、タスクが完了するまで待ってから修正を指示する必要がありましたが、Codex-Sparkではリアルタイムに軌道修正しながら作業を進められるため、対話的なペアプログラミングに近い体験が得られるかと思います。

なお、エージェント型AIについて、詳しく知りたい方は以下の記事も参考にしてみてください。

GPT-5.3-Codex-Sparkの安全性・制約

GPT-5.3-Codex-Sparkは現時点でリサーチプレビューの段階にあり、いくつかの制約が存在します。

入力はテキストのみ対応で、画像などのマルチモーダル入力には未対応です。また、コンテキストウィンドウは128Kトークンとなっています。

さらに、専用のレート制限が設けられていて、需要が集中した場合には、アクセスの一時制限やキューイングが発生する可能性があるとOpenAIは説明しています。

GPT-5.3-Codex-Sparkの料金

GPT-5.3-Codex-Sparkは、ChatGPTの有料プランに含まれる「Codex」機能の一部として提供されています。

| プラン | 月額料金 | GPT-5.3-Codex-Spark利用可否 |

|---|---|---|

| 無料版 | – |  |

| ChatGPT Go | 8ドル |  |

| ChatGPT Plus | 20ドル |  (Codex自体は利用可能) (Codex自体は利用可能) |

| ChatGPT Pro | 200ドル |  |

| ChatGPT Team | 30ドル |  (Codex自体は利用可能) (Codex自体は利用可能) |

なお、ChatGPTの料金プランに関しては下記の記事を参考にしてください。

GPT-5.3-Codex-Sparkのライセンス

GPT-5.3-Codex-Sparkのライセンスは、モデル本体と、Codex CLIの2つに分けて考える必要があります。

モデル本体は、OpenAIの利用規約(Service Terms)に準拠するプロプライエタリなクラウドサービスとして提供されています。一方、Codex CLIは、GitHub上でApache License 2.0のオープンソースとして公開されています。

| 利用用途 | 可否 | 備考 |

|---|---|---|

| 商用利用 |  | |

| 改変 |  | モデル自体の改変不可 |

| 配布 |  | モデル自体の配布不可 |

| 特許使用 | – | |

| 私的使用 |  |

GPT-5.3-Codex-Sparkの使い方

GPT-5.3-Codex-Sparkは、Codexアプリ、CLI、VS Code拡張機能の3つの方法で利用できます。いずれもChatGPT Proプランへの加入が前提です。ここでは、それぞれの手順をステップ・バイ・ステップで解説します。

Codex CLIから使う方法

Codex CLIはターミナル上で動作するエージェントツールです。もっとも素早くCodex-Sparkを試すことができます。

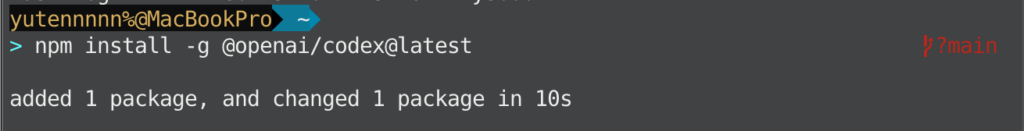

Codex CLIを最新版にアップデートする

まだCodex CLIをインストールしていない場合、またはバージョンが古い場合は、以下のコマンドで最新版(v0.101.0以降)をインストールします。

npm install -g @openai/codex@latest

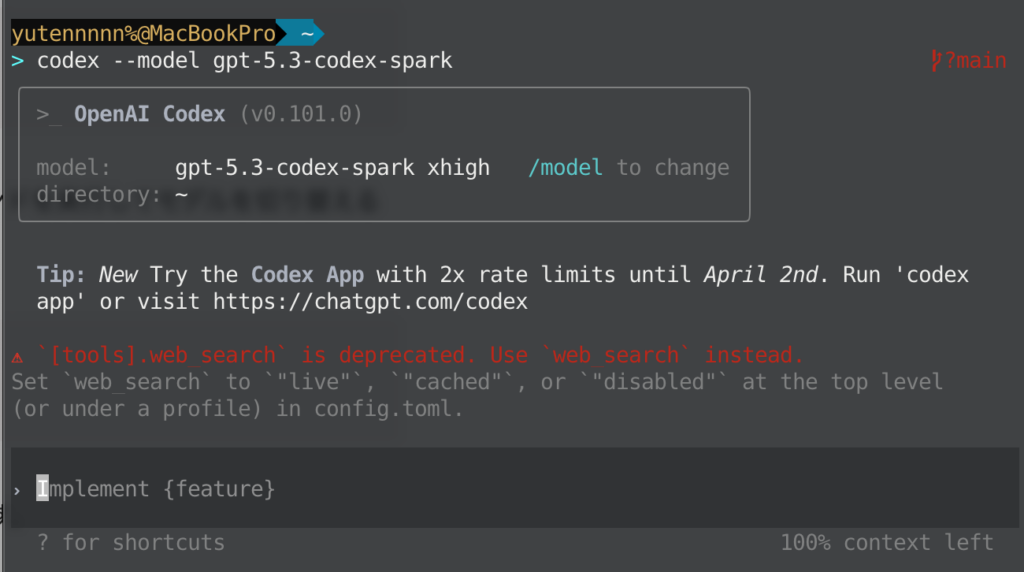

Codex-Sparkモデルを指定して起動する

新しいスレッドを開始する際に --model オプションでCodex-Sparkを指定します。

codex --model gpt-5.3-codex-spark

すでにCodexのセッションを開いている場合は、セッション内で /model コマンドを実行してモデルを切り替えることもできます。

/model表示されるモデル一覧から「GPT-5.3-Codex-Spark」を選択すれば切り替え完了です。

コーディングタスクを指示する

あとは通常のCodexと同じように、自然言語でタスクを指示するだけです。たとえば、以下のように入力します。

この関数のエラーハンドリングを改善してCodex-Sparkはピンポイントな編集を高速で返してくれます。作業中に方向を修正したくなった場合は、モデルが応答している途中でも追加の指示を送信できます。

VS Code拡張機能から使う方法

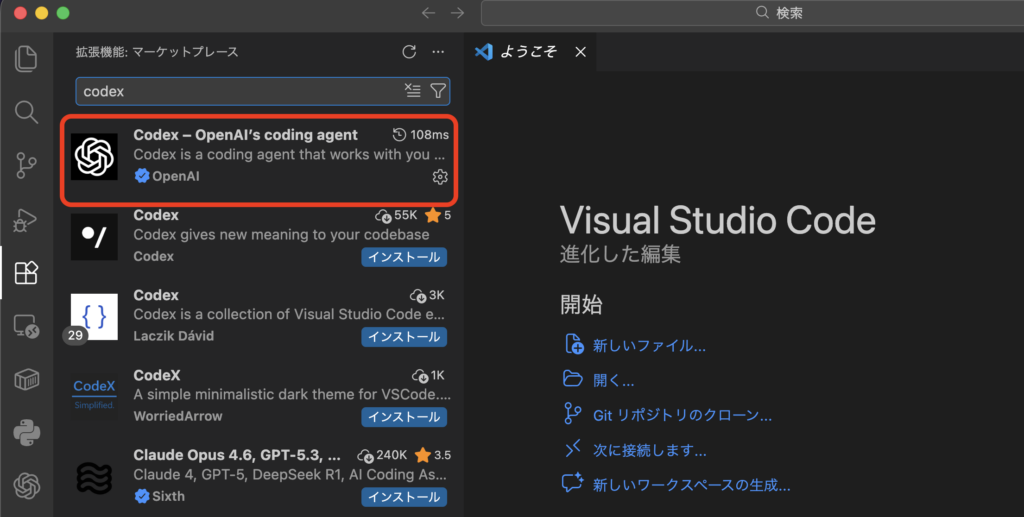

Codex拡張機能を最新版に更新する

VS Codeの拡張機能メニューからCodex拡張機能を検索し、最新版にアップデートしてください。

ChatGPTアカウントでサインインする

拡張機能内でChatGPTアカウント(Proプラン)にサインインします。

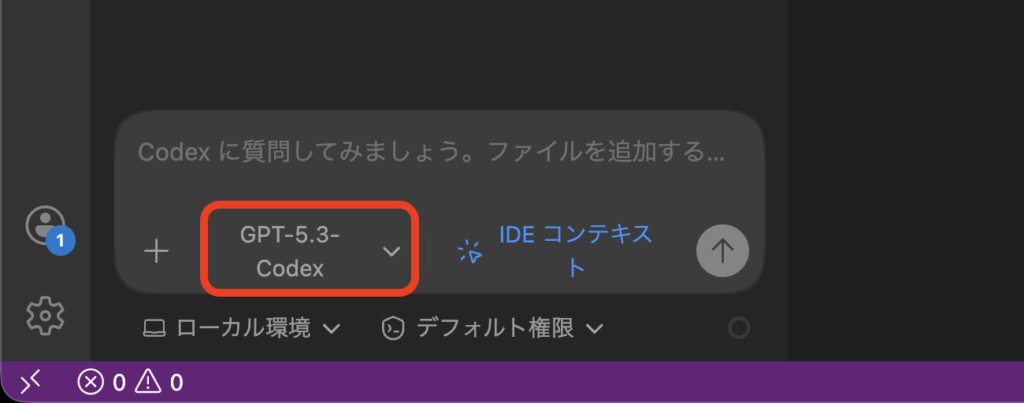

モデルセレクターからCodex-Sparkを選択する

コンポーザー(入力画面)下部のモデルセレクターをクリックし、一覧から「GPT-5.3-Codex-Spark」を選びます。

選択後は、コンポーザーに指示を入力するだけでCodex-Sparkが応答します。

Codexアプリ(デスクトップ)から使う方法

Codexアプリを最新版にアップデートする

macOS版のCodexアプリを最新バージョンに更新してください。

ChatGPTアカウントでサインインする

Proプランのアカウントでサインインします。

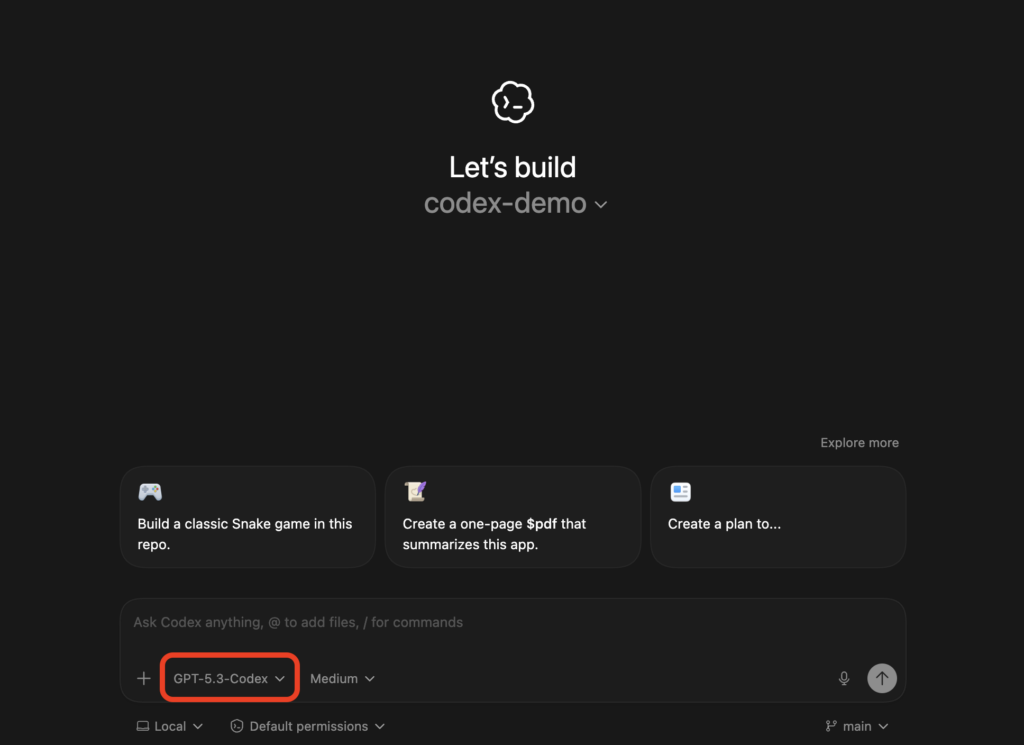

モデルセレクターからCodex-Sparkを選択する

コンポーザーのモデルセレクターから「GPT-5.3-Codex-Spark」を選択して使い始めます。

ファイルのドラッグ&ドロップにも対応しているため、対象ファイルを直接添付して指示を出すことも可能です。

Codex-Sparkが一覧に表示されない場合は、アプリ・CLI・拡張機能を最新バージョンに更新してみてください。

【業界別】GPT-5.3-Codex-Sparkの活用シーン

GPT-5.3-Codex-Sparkはリアルタイム性が強みのモデルです。ここでは、業界ごとにどのような活用が考えられるかを紹介します。

Web開発・フロントエンド

UIコンポーネントの微調整やスタイリングの修正は、何度も試行錯誤を繰り返す作業です。

そこでCodex-Sparkの高速応答を活かせば、レイアウトの変更やCSSの調整を即座に反映させながら、対話的にデザインを詰めていくことができます。

DevOps・インフラ

デバッグ、デプロイ、モニタリングといったDevOps領域のタスクもCodex-Sparkの守備範囲です。SiliconANGLEの報道によれば、Codex-Sparkは単なるコーディングにとどまらず、PRD(製品要件定義書)の作成やコピーの編集、テスト設計、メトリクスの確認まで幅広くカバーするとされています。

教育業界

プログラミング学習において「すぐにフィードバックが返ってくる」ことの価値は非常に大きいです。

Codex-Sparkは、学習者がコードを書きながらリアルタイムで質問し、即座に修正提案を受け取るという対話的な学習体験を提供できます。

なお、教育業界における生成AI活用について、詳しく知りたい方は以下の記事も参考にしてみてください。

研究開発

研究コードの素早い検証やデータ処理スクリプトの作成など、試行錯誤の回数が多い研究開発の現場でも、Codex-Sparkの速度は大きなアドバンテージになります。

仮説を立ててすぐにコードで検証し、結果を見て次の仮説に進むという高速サイクルを回すことができます。

なお、生成AIを活用した研究開発について詳しく知りたい方は下記の記事を参考にしてください。

【課題別】GPT-5.3-Codex-Sparkが解決できること

ここでは、開発者が日常的に直面する課題に対して、Codex-Sparkがどのように役立つかを整理します。

AIコーディングツールの応答待ち時間が長い

従来のCodexモデルでは、複雑なタスクに対して数十秒から数分の応答時間がかかることがありました。

Codex-Sparkは、秒速1,000トークン超の生成速度で、多くの対話的タスクを数秒以内に処理します。思考の流れが途切れることなく、コーディングに集中し続けられるのが最大のメリットです。

なお、生成AIを活用した業務効率化・コスト削減について知りたい方は、以下の記事も参考にしてみてください。

リアルタイムで方向修正ができない

AIに指示を出してから結果が返ってくるまで待ち、そこで初めて「違う、こうしてほしかった」と気づく経験は開発者のみなさんなら一度はあるかと思います。

Codex-Sparkのミッドターンステアリング機能により、モデルの作業中にリアルタイムで割り込んで方向を修正できます。

小さな修正のためだけに大きなモデルを動かすのは非効率

変数名の変更やちょっとしたリファクタリングなど、数行レベルの編集に大規模モデルをフル稼働させるのはオーバースペックです。

Codex-Sparkは、デフォルトで最小限のピンポイント編集を行う設計になっており、こうした日常的な小さな修正作業を効率的に処理します。

よくある質問

まとめ

GPT-5.3-Codex-Sparkは、OpenAIがCerebras社との提携を通じて送り出した、リアルタイムコーディングに特化した初のモデルです。

秒速1,000トークン超の生成速度、ミッドターンステアリングによる対話的な作業体験、そしてピンポイントな最小限の編集というデフォルト設計により、開発者の「考える速度」に追従するAIコーディングツールを実現しています。

気になった方は、ぜひ一度試してみてください。

最後に

いかがだったでしょうか?

弊社では、AI導入を検討中の企業向けに、業務効率化や新しい価値創出を支援する情報提供・導入支援を行っています。最新のAIを活用し、効率的な業務改善や高度な分析が可能です。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、大規模言語モデル(LLM)を対象に、言語理解能力、生成能力、応答速度の各側面について比較・検証した資料も配布しております。この機会にぜひご活用ください。