- Stability AIが開発した画像生成AI「Stable Diffusion」を、Webブラウザ上で手軽に利用できるアプリ。

- オープンソースで無料利用可能。商用可否はモデルのライセンスで異なるため、各モデルのCreativeML OpenRAIL-M等を確認。

- オフラインでも利用できるためセキュリティ面で安心。

みなさんは、Stable DiffusionをWebブラウザ上で手軽に利用できる「Stable Diffusion Web UI」をご存知でしょうか?

画像生成の自由度が高いのはもちろん、無料で利用できるのがなによりの利点です。

今回は、Stable Diffusion Web UIの概要や導入方法、使い方などを詳しく解説していきます。最後まで目を通すと、自身のPCで手軽にAI画像生成ができるようになるので、クリエイティブな仕事が捗ること間違いありません。

ぜひ最後までご覧ください。

\生成AIを活用して業務プロセスを自動化/

- Stable Diffusionとは

- Stable Diffusion Web UIとは

- txt2imgとimg2imgの違い

- Stable Diffusion Web UIを利用するメリット

- Stable Diffusion Web UIのダウンロード手順

- Stable Diffusion Web UIの使い方

- よくあるトラブルと解決方法

- Stable Diffusion Web UIを使って画像を生成してみた

- Stable Diffusion Web UIを日本語化する方法

- Stable Diffusion Web UIの拡張機能について

- Stable Diffusion Web UIを利用する際の注意点

- 他の画像生成AIとの比較

- Stable Diffusion Web UIの活用事例

- Stable Diffusion Web UIでよくある質問

- Stable Diffusion Web UIで画像を生成してみよう!

- 最後に

Stable Diffusionとは

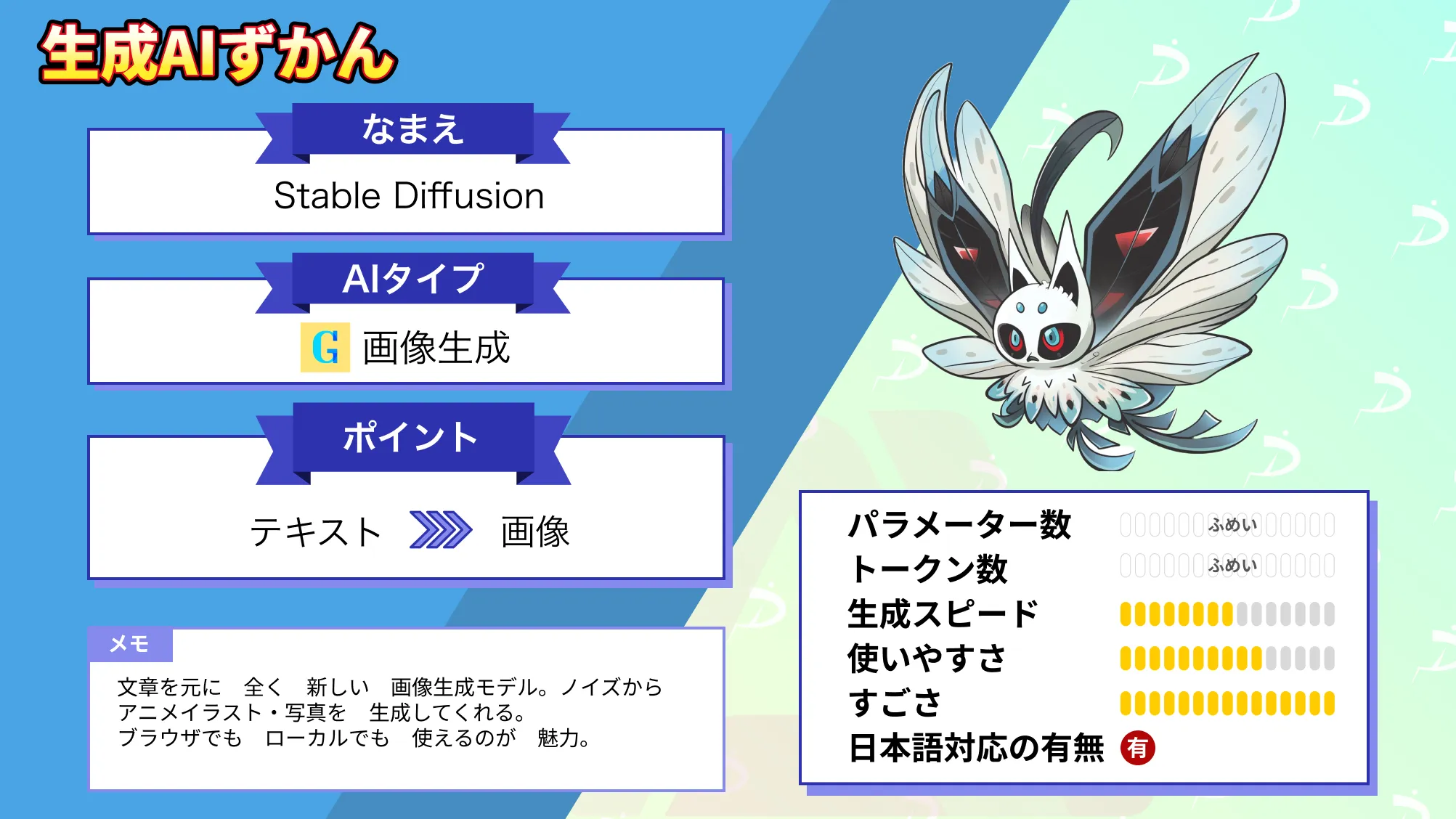

Stable Diffusionとは、Stability AIが開発した画像生成AIです。訓練済みのAIモデル「Diffusion Model」を搭載しており、日本語プロンプトに対する高い理解力を備えています。

Stable Diffusionは、画像生成AIの代表モデルともいえる生成AIで、テキスト入力から手軽に画像を生成できるのが特徴。image to imageにも対応しているので、参照画像をもとに新たな画像を生成することも可能です。

また、Stable Diffusionはオープンソースで公開されているので、無料でも利用できるのが魅力。生成した画像の所有権は基本的にユーザーにあるので、一部の学習モデルを除けば商用利用も認められています。ただし、商用可否はモデルのライセンスで異なるため、各モデルのCreativeML OpenRAIL-M等を確認してください。

なお、Stable Diffusionについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

Stable Diffusion Web UIとは

Stable Diffusion Web UIとは、Webブラウザを通して、無料でStable Diffusionを利用できるアプリです。その名の通り、Web UIによる手軽な操作性が魅力で、プログラミングなどの複雑な工程は発生しません。

そのため、初心者でも比較的簡単に画像生成を始められます。ローカル環境にインストールして使用するため、インターネット接続が不要であり、プライバシーを確保しながら高品質な画像を作成できる点も特徴です。

また、拡張機能を追加することで、より高度なカスタマイズや表現の幅を広げられます。

AUTOMATIC1111版とForge版の違い

| 項目 | AUTOMATIC1111版 | Forge版 |

|---|---|---|

| リリース時期 | 早い(開発が長く続いている) | 比較的新しい |

| 動作の安定性 | 安定性が高く、動作実績が豊富 | 一部の環境では安定性に課題あり |

| 拡張機能の対応 | 多くの拡張機能が利用可能 | 一部未対応の拡張機能あり |

| VRAM使用量 | 多め(高性能なGPU推奨) | 少なめ(VRAM 4GBでも動作可能) |

| 動作速度 | 標準的 | VRAMの最適化により高速 |

| ドキュメントの豊富さ | 公式・非公式の情報が充実 | 情報が少なく、AUTOMATIC1111版の知識が必要になることも |

| おすすめの用途 | 多機能を活用した高度な画像生成 | 軽量PCやVRAMの少ない環境向け |

Stable Diffusion Web UIには、AUTOMATIC1111版とForge版の2種類が存在します。AUTOMATIC1111版はForge版よりも前からリリースされているのが特徴で、ドキュメントの豊富さと安定した動作が魅力です。

長年の開発により、数多くの拡張機能やカスタマイズオプションが提供されており、多様な用途に対応できます。

一方、Forge版はVRAMを節約しながら高速に画像生成ができるため、スペックの低いPCでも動作しやすいのが強みです。特に、VRAMが8GB以下の環境では顕著なパフォーマンス向上が期待できます。※3

AUTOMATIC1111版とほぼ同じUIで利用できるため、操作に戸惑うことはありません。また、Forge版では特定のアルゴリズムの最適化により、より効率的な画像生成が可能になっています。

txt2imgとimg2imgの違い

Stable Diffusion Web UIでは、画像生成方法として「txt2img」と「img2img」の2つの機能が用意されています。

「txt2img」は、テキスト(プロンプト)のみをもとに画像を生成する機能です。例えば、「湖のほとりに立つ白い教会」のような文章を入力するだけで、AIがそのイメージに沿った画像を一から描き出します。構図や色合いなども自動的に決定されるため、まったく新しい発想の画像を生み出したいときに最適です。

一方、「img2img」は、もととなる画像にテキストを組み合わせて、新たな画像を生成する機能です。入力画像の構図や雰囲気を保ちつつ、スタイルや細部を変更できるため、ラフスケッチを清書したり、写真をイラスト風に変換したりといった用途に向いています。また、もとの画像の影響度合いは設定で調整可能で、微妙な変化から大胆な変化まで柔軟に対応できます。

両者を使い分けることで、アイデア出しから仕上げ作業まで、画像制作の幅が大きく広がります。

Stable Diffusion Web UIを利用するメリット

Stable Diffusion Web UIを利用するメリットは、以下の3つです。

- 無料で利用できる

- カスタマイズが可能

- オフラインでも利用可能

特に、高品質な画像を無料で生成できるのが大きな魅力です。

以下で、それぞれのメリットを紹介していくので、ぜひ参考にしてみてください。

無料で利用できる

Stable Diffusion Web UIは、オープンソースで公開されているので、誰でも無料で利用できます。どこかのサイトに会員登録をする必要もありません。

ほかの画像生成を利用する際は、月額もしくは従量課金で費用を請求されることが多いので、これは大きなメリットですね!

カスタマイズが可能

Stable Diffusion Web UIでは、拡張機能を利用して生成画像をカスタマイズできます。LoraやControlNetといった、コミュニティによって開発されたさまざまな拡張機能を利用可能です。

例えば、Loraを使用すると、アニメ風の画像やリアルな人間の画像など、特定のタスクに特化させられます。ニーズに沿った質の高い画像生成ができるようになるので、ぜひ試してみてください。

オフラインでも利用可能

Stable Diffusion Web UIは、オフラインでも利用できます。インターネット接続なしで作業がローカル上で完結するため、セキュリティ面での懸念を払拭できるのがメリットです。

ただし、PCのCPUやGPUのスペックによっては快適に動作しない場合があるため、スペック要件を事前に確認しておくと安心です。

Stable Diffusion Web UIのダウンロード手順

ここからは、Stable Diffusion Web UIの導入方法をご紹介します。WindowsやMacなどのOS別に、AUTOMATIC1111版のダウンロード手順を解説するので参考にしてみてください。

Windowsのダウンロード手順

必要スペック※1

- CPU:6コア以上(Core i5-11400以上/Ryzen 5 5600以上 推奨)

- メモリ:最低16GB、拡張機能を使用するなら32GB以上推奨

- GPU(VRAM):最低6〜8GB(RTX 2060以上)、推奨はRTX 3060(12GB)以上

- ストレージ(SSD):最低250GB(複数モデル使用予定なら512GB以上推奨)

- OS:Windows 10/11(64bit)

WindowでStable Diffusion Web UIをダウンロードする際は、おもに以下3つのステップに沿って実施します。

- Pythonのダウンロード

- gitのダウンロード

- Stable Diffusion Web UIのダウンロード

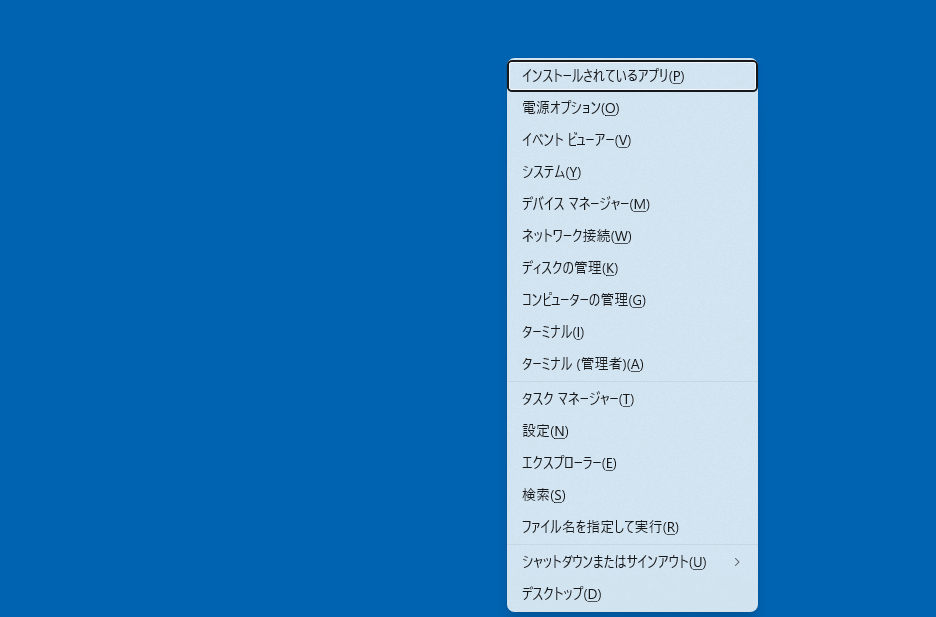

まずは、Pythonとgitをダウンロードするために、自身が使っているWindowsのビット数を確認します。

デスクトップでWindowsキー+Xキーを押して、上から4つ目にある「システム」をクリックしてください。

デバイス仕様の「システムの種類」を確認すれば、ビット数がわかります。

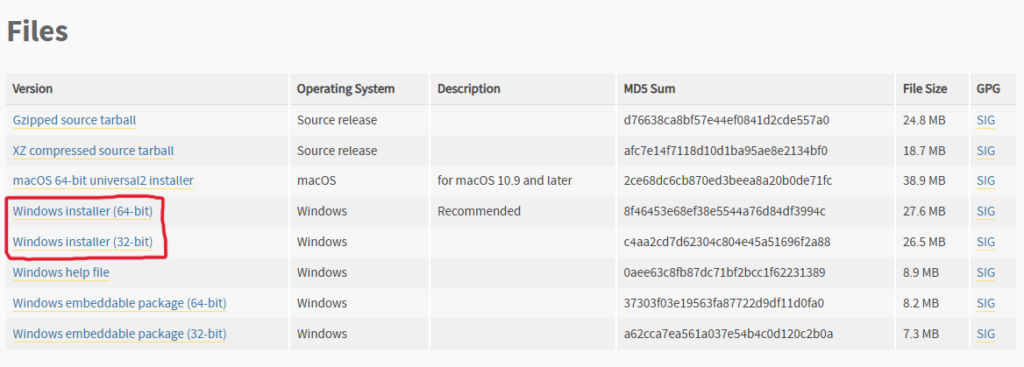

次はPython公式サイトにアクセスして、Python 3.10.6のインストーラーをダウンロードします。

上記赤枠部分のどちらかビット数が自身のPCと一致するものをダウンロードしてください。

ダウンロードしたインストーラーを開きます。

「Add Python 3.10 to PATH」にチェックを入れて、「Install Now」をクリックしてください。

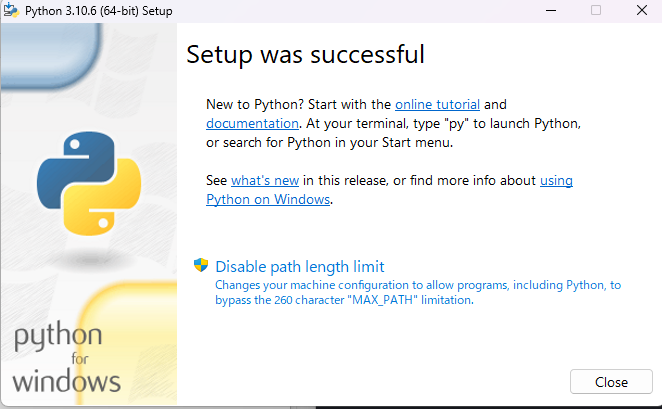

以下の画面が表示されたら、Pythonのダウンロードは完了です。

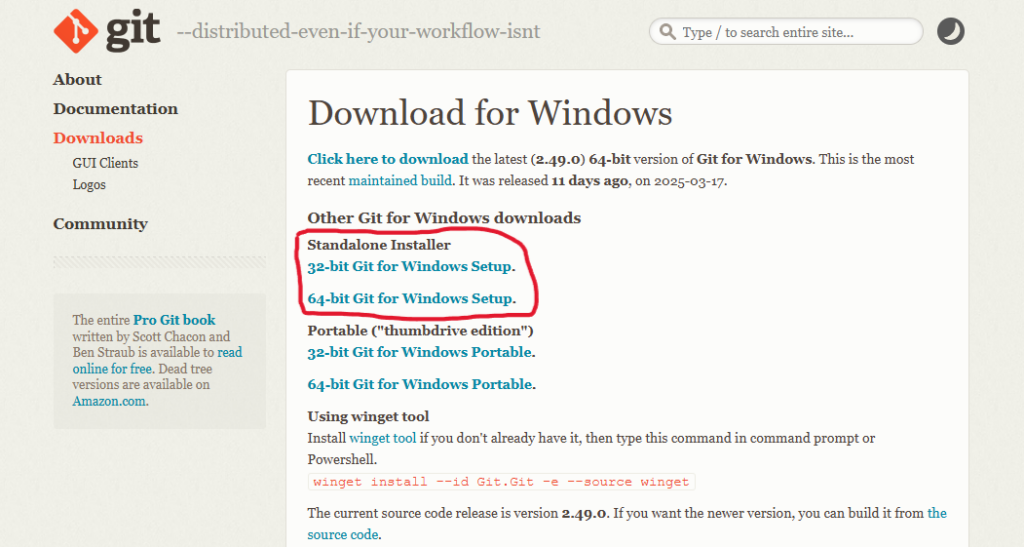

次は、gitの公式サイトにアクセスして、gitのインストーラーをダウンロードします。

Python同様、自身のPCのビット数と一致するものをダウンロードしてください。

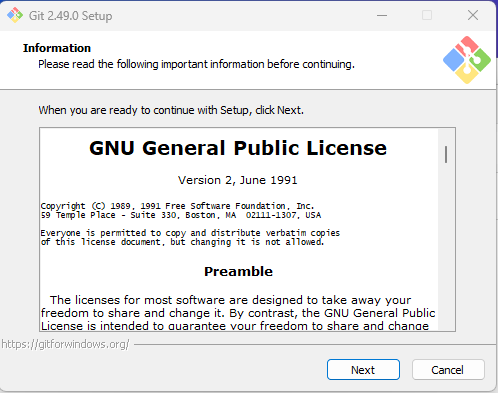

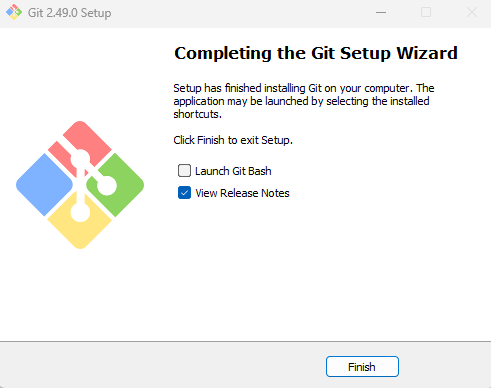

ダウンロード後は、gitのインストーラーを開きます。

gitのインストーラーを立ち上げると、いくつかの項目が立て続けに表示されますが、全て何もいじらずに「Next」をクリックしてください。

以下の画面が表示されれば、gitのダウンロードは完了です。

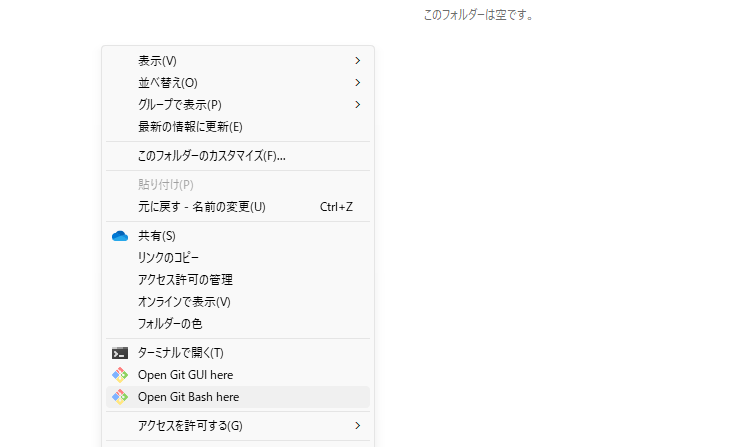

次は、Stable Diffusion WebUI関連のファイルを格納する任意のフォルダを開きます。

右クリックして、「Open Git Bash here」をクリックしてターミナルを開きましょう。

右クリックしても「Open Git Bash here」が見つからない場合は、「その他のオプションを確認」を押すと出てきます。

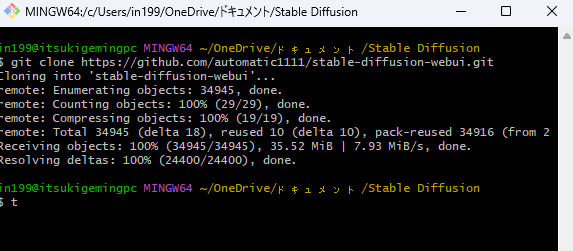

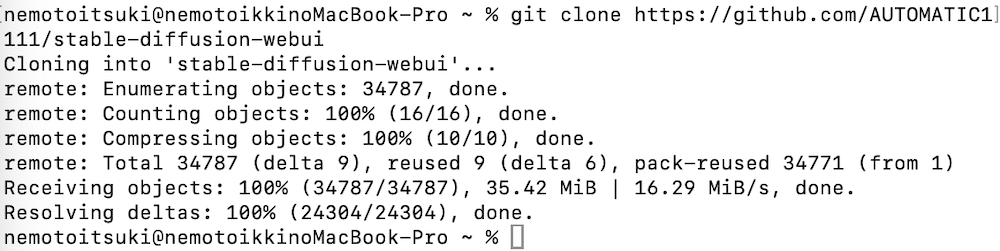

ターミナルを開いたら、以下のコマンドを入力します。

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.gitコマンドを入力すると、Stable Diffusion Web UIがローカル環境にダウンロードされ、以下画面のファイルが作成されます。

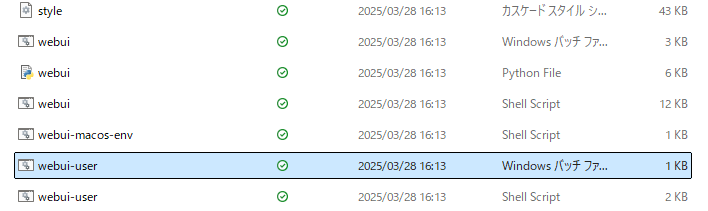

上記ファイルを開き、「webui-user.bat」もしくは「webui-user」と表示されているWindowsパッチファイルを開きます。

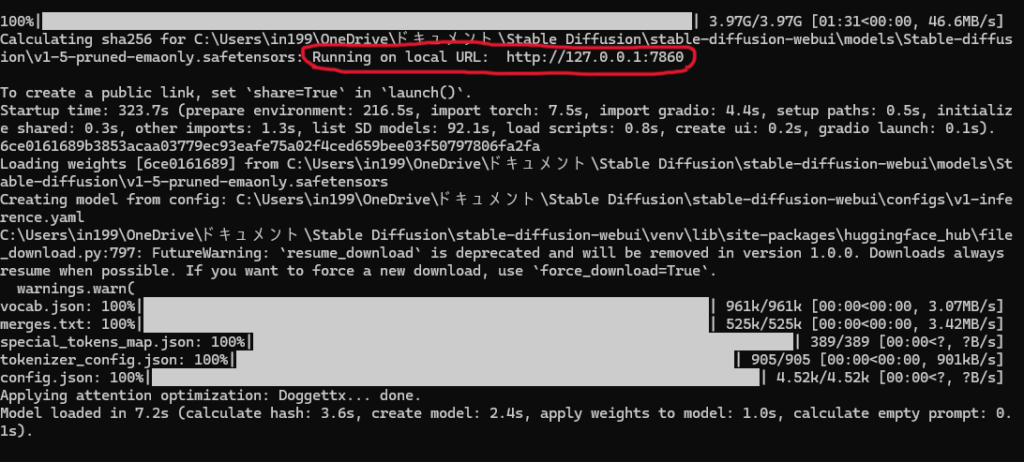

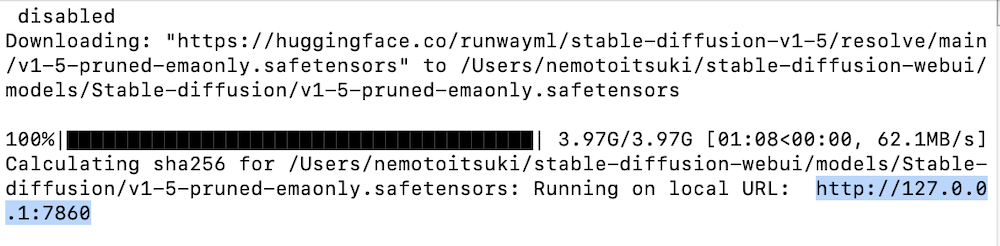

ファイルを開いてしばらくすると、ターミナルに「Running on local URL: http://127.0.0.1:7860」が表示されて、自動的にWebブラウザ上でStable Diffusion Web UIが立ち上がります。

Macのダウンロード手順

必要スペック※2

- チップ:Apple Silicon(M1/M1 Pro/M1 Max/M2/M2 Pro/M2 Max)搭載Mac

- メモリ:最低16GB、生成や拡張機能利用なら32GB以上推奨

- ストレージ:最低128 GB(Web UI+モデル1~2個)、余裕があるなら250~512GB以上推奨

- OS:macOS Monterey以降(Ventura/Sonomaなど)

- 備考:AUTOMATIC1111ではMetal GPUの活用は限定的のため、生成速度はCPU主体。より高速な生成や安定性を求めるなら、InvokeAIやDraw ThingsなどCore ML対応アプリも検討すると良い

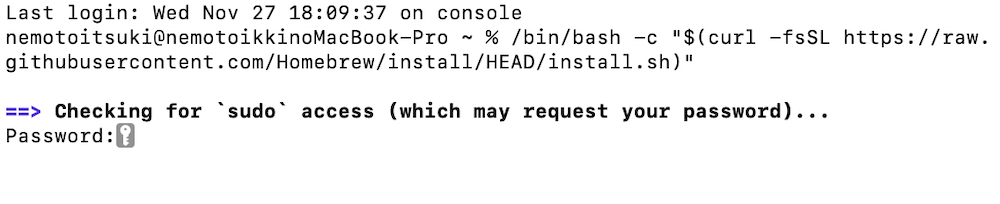

まずは、アプリ一覧から「ターミナル」を開いて、「Homebrew」をインストールします。

「Homebrew」をインストールする際は、以下のコードをターミナルにコピペしてください。

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

パスワードの入力を求められるので、いつもMacを開くときに使用しているパスワードを入力します。

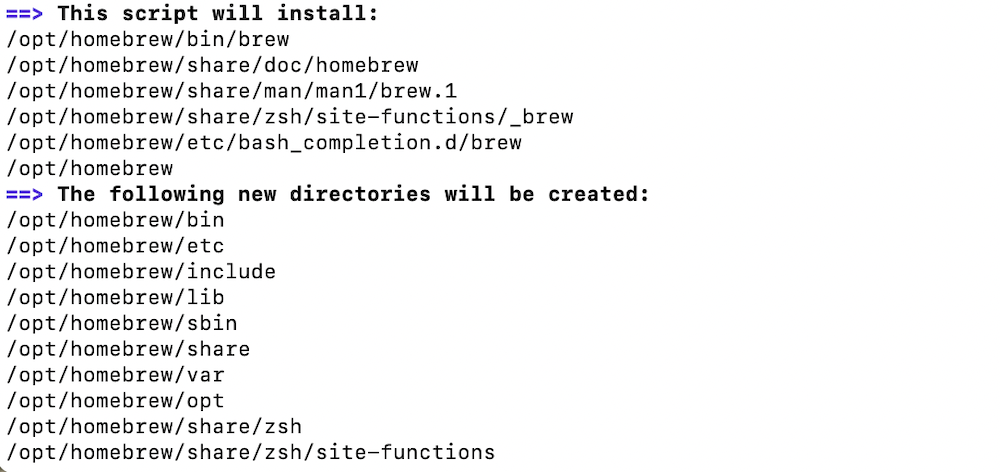

パスワードの入力後はenterを押して、Homebrewのインストールが終わるのを待ってください。

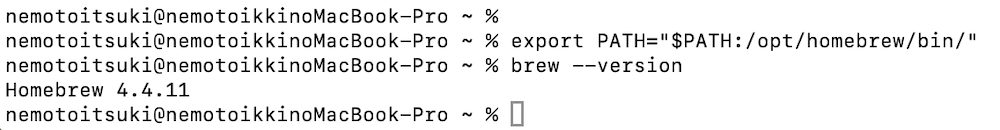

次はターミナルに以下のコマンドを入れます。

export PATH="$PATH:/opt/homebrew/bin/"以下のコマンドを入力して、インストールが完了していることやPATHが通っているか確認しましょう。

brew --version以下の画像のような画面になればOKです。

筆者も直面しましたが、Homebrewのインストール中に「zsh: command not found: brew」と表示されてエラーになることがあります。

その際は、ファインダーから「ターミナル」を検索して、右クリックで「情報を見る」を選択します。その後、「Rosettaを使用して開く」にチェックを入れて、PCを再起動してからもう一度やり直してみてください。

今度はいよいよ、Stable Diffusion Web UIをダウンロードします。

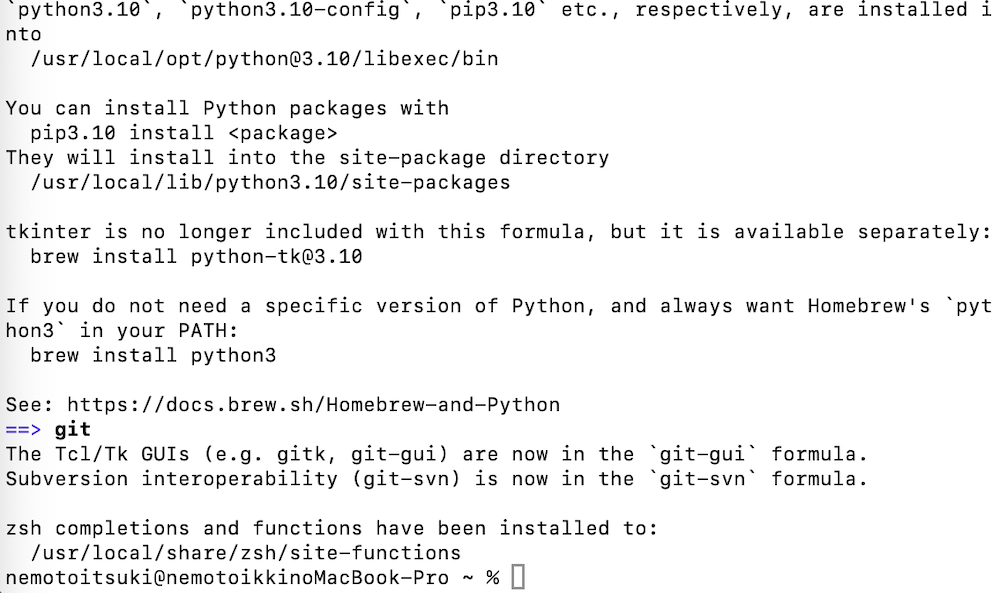

以下のコマンドを入力して、必要なライブラリをインストールしてください。今回は、AUTOMATIC1111版をインストールしています。

brew install cmake protobuf rust python@3.10 git wgetインストール後の画面がこちらです。

続いて、以下のコマンドを入力して、Stable Diffusion Web UIのリポジトリをローカルPCにcloneしてください。

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

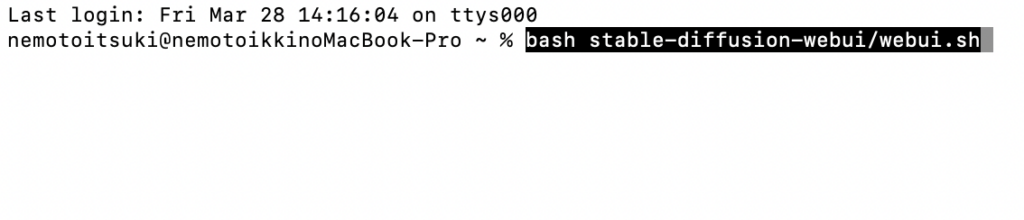

今度は、以下のコマンドを実行して、いよいよStable Diffusion Web UIを起動します。

bash stable-diffusion-webui/webui.sh正常に動作すると、以下画面のように「Running on local URL: http://127.0.0.1:7860」が表示されます。

この時点で、Stable Diffusion Web UIが自動でブラウザ上で立ち上がるので、実際に利用してみてください。

Google Colabのダウンロード手順

Google ColabでStable Diffusion Web UIをダウンロードする際は、有料版のGoogle Colab Proの契約が必要です。

無料版だとGoogle Colabの利用規約に引っ掛かり、Stable Diffusion Web UIのダウンロードや起動がうまくできません。

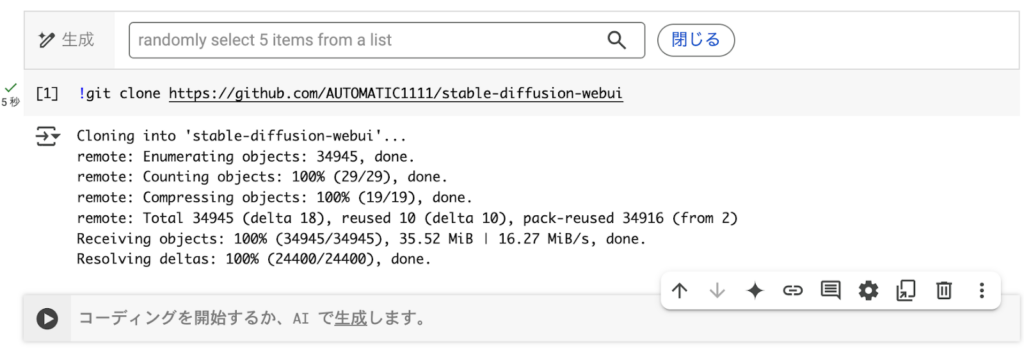

有料版を契約したうえで、Google Colabにアクセスして新しいファイルを立ち上げます。

その後、以下のコマンドを実行してShift+Enterを押してください。

!git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui

これで、Google colabにAUTOMATIC1111/stable-diffusion-webuiのリポジトリを複製できました。

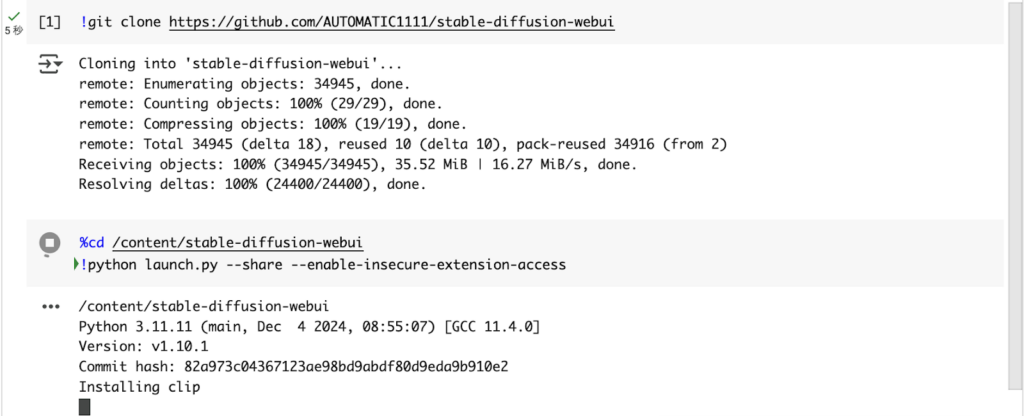

次は以下のコマンドを実行して、Stable Diffusion Web UIをダウンロードします。

%cd /content/stable-diffusion-webui

!python launch.py --share --enable-insecure-extension-access

コマンドの実行後に、[Running on public URL: https//xxxxx.gradio.live]が表示されれば完了です。

あとはリンクをクリックして、Stable Diffusion Web UIを起動しましょう。

Stable Diffusion Web UIの起動方法

Stable Diffusion Web UIを1度起動した場合、2回目以降の起動は簡単です。

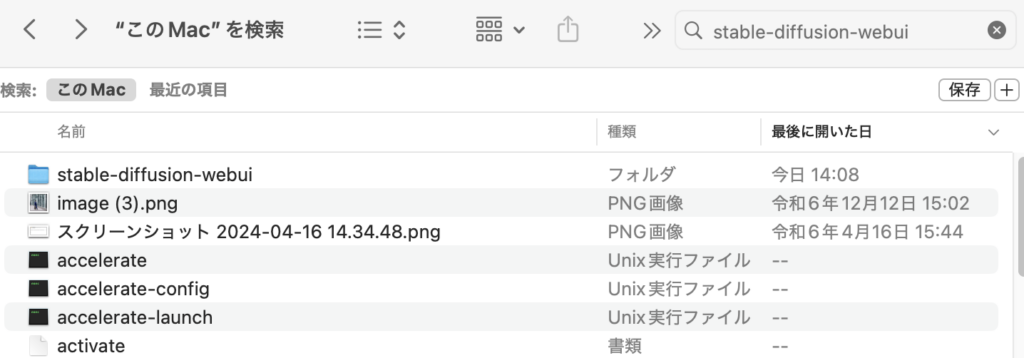

まずは、PCのローカルフォルダで[stable-diffusion-webui]のファイルを検索してください。

その後、[stable-diffusion-webui]→[webui-user.bat]の順で開くと自動的にStable Diffusion Web UIが起動します。

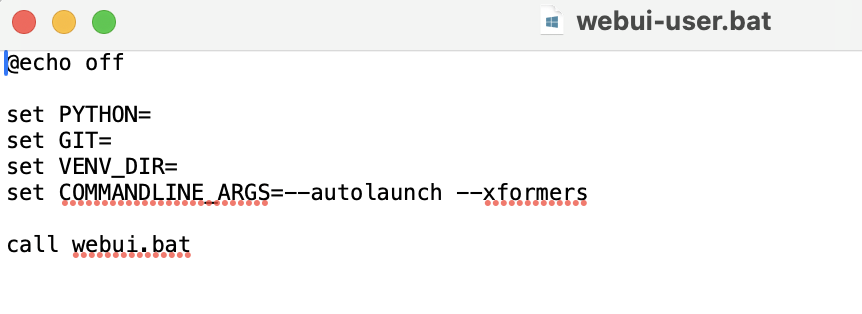

Stable Diffusion Web UIの自動起動の設定をしていない場合は起動しないので、そのときは[webui-user.bat]をテキストエディットなどのメモで開いて「set COMMANDLINE」に「–autolaunch –xformers 」の書き込みを追加してください。

この手順で起動しない場合でも、ターミナル(Macの場合)で以下のコマンドを入力すれば、自動的にブラウザ上でStable Diffusion Web UIが起動します。

bash stable-diffusion-webui/webui.sh

Stable Diffusion Web UIを起動できない場合の対応策

Stable Diffusion Web UIの起動を試みた際に、何らかの影響でエラーになることもあります。

おもな理由は、PythonのバージョンがStable Diffusion Web UIが推奨している「python3.10.6」になっていないことが挙げられます。

この場合は、以下のコマンドを入力してください。

brew update

brew install pyenv続けて、以下2つのコマンドを1つずつ入力していきます。

echo 'export PYENV_ROOT="$HOME/.pyenv"' >> ~/.zshrc

echo 'export PATH="$PYENV_ROOT/bin:$PATH"' >> ~/.zshrc

echo 'eval "$(pyenv init --path)"' >> ~/.zshrcsource ~/.zshrcここまでで、Pythonをインストールする準備が一通り整ったので、次は以下のコマンドを実行してください。

pyenv install 3.10.6あとは、上記のPythonバージョンをシステムで使用できるように、以下のコマンドを実行します。

pyenv global 3.10.6以下のコードを実行すれば、現在反映されているPythonのバージョンを確認できます。

python --versionこの時点で、「python3.10.6」が指定されていれば成功なので、再度以下のコードを実行してStable Diffusion Web UIを起動してみてください。

bash stable-diffusion-webui/webui.shこれでもまだエラーが出る場合は、ほかにも要因があるので、エラーメッセージをそのままChatGPTに入力して、原因や解決方法を聞いてみてください。

実際、筆者も何度もエラーが出たのですが、ChatGPTに聞いてその通りにコマンドを実行していったら、Stable Diffusion Web UIを起動できました。

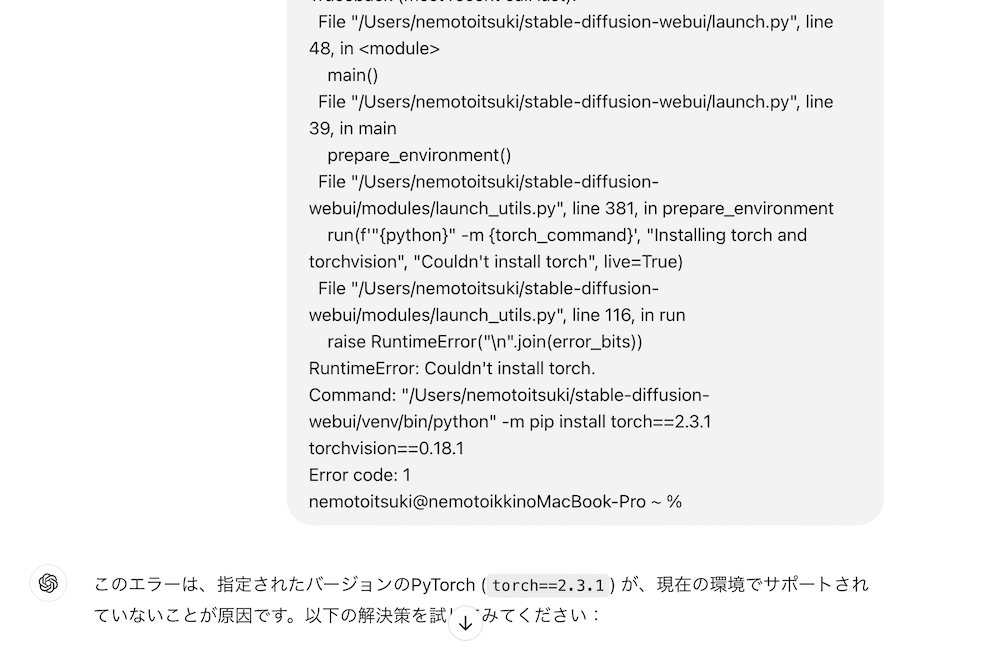

筆者の場合は、指定されたPyTorchバージョン(torch=2.3.1)が現在の環境で利用できなかったので、対応するPyTorchを手動でインストールしています。

おそらく、いろいろなサイトで解決策を探すよりも楽に解決できるはずです。

今回はAUTOMATIC1111版のダウンロード手順を紹介しましたが、Forge版のダウンロード手順書気になる方は以下の記事をご覧ください。

Stable Diffusion Web UIの使い方

ここからは、Stable Diffusion Web UIの使い方を解説していきます。

基本操作から応用まで紹介しているので、ぜひ参考にしてみてください。

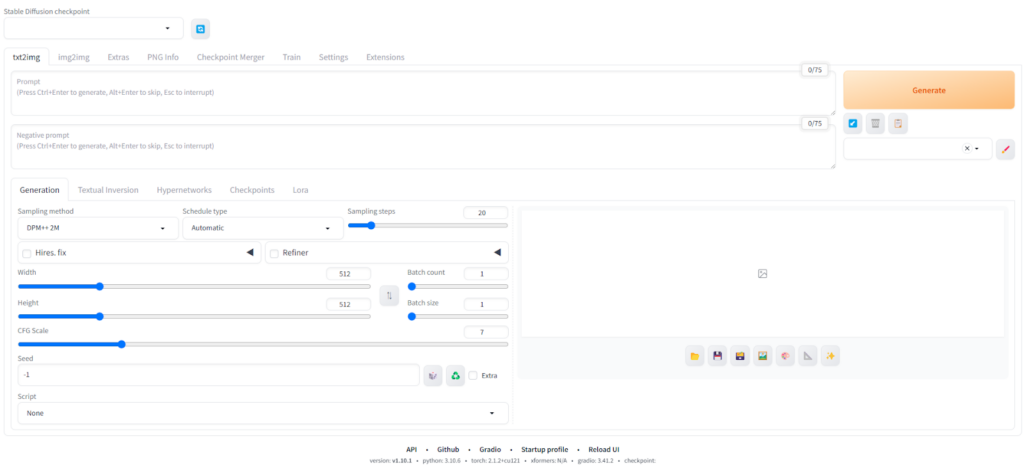

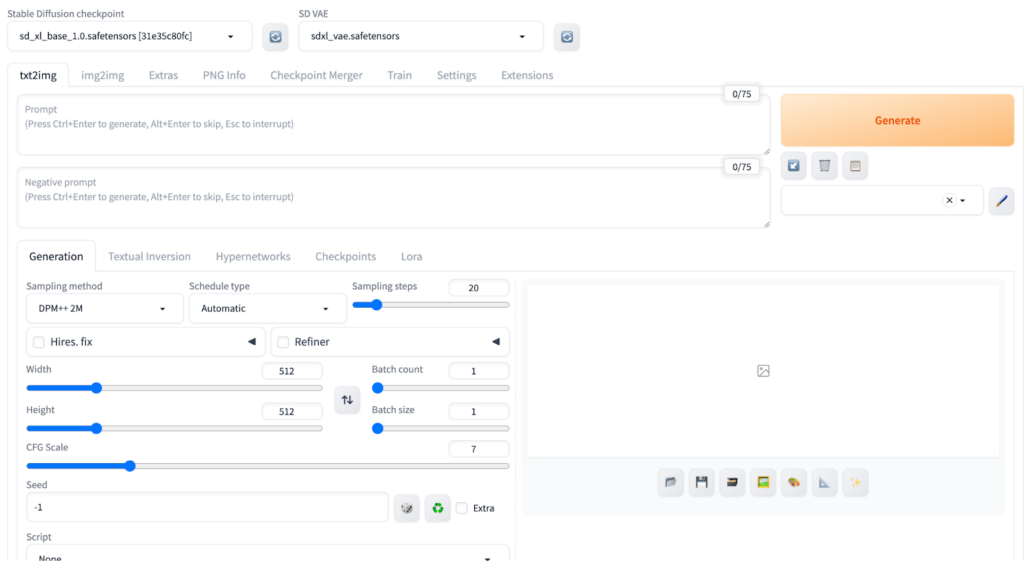

Web UIの基本操作(テキストから画像を生成)

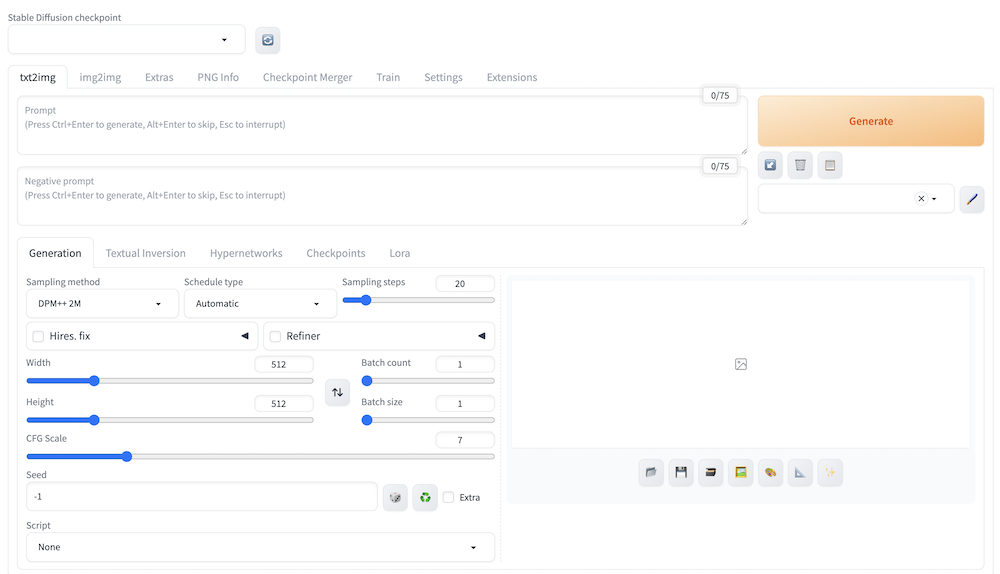

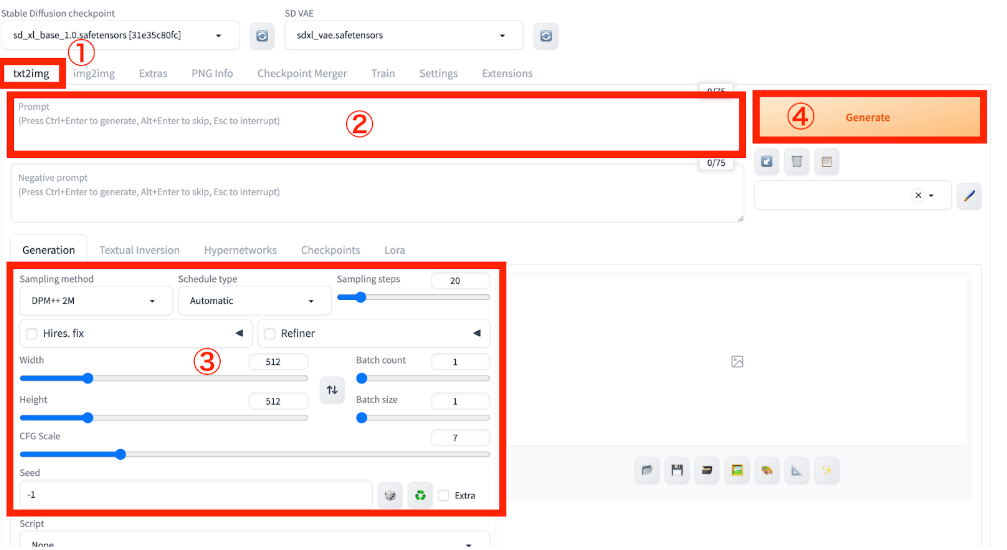

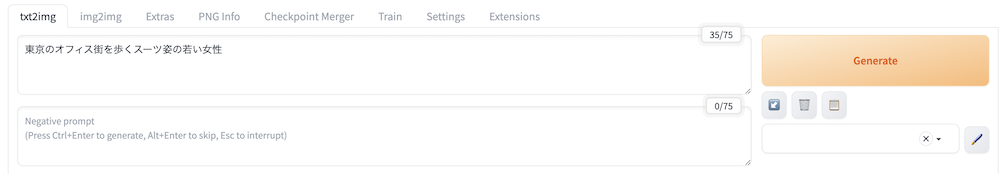

まずは、Stable Diffusion Web UIの見方や基本となるtxt2img(テキストから画像を生成)のやり方を解説します。

テキストから画像を生成する際は、上記画像の①に注目してtxt2imgを選択します。その後は②の部分にプロンプトを入力して、必要ならその下にネガティブプロンプト(画像に反映させたくない要素)を入力して指定しましょう。

③では各種パラメータの調整ができます。

| パラメータ | 意味 |

|---|---|

| Sampling method | サンプリング手法。手法によって生成速度や画像の品質が変わる。 |

| Sampling steps | サンプリングステップ数。値が大きいほど画像の品質が良くなるが、生成速度が落ちる。 |

| Width、Height | 画像のサイズ。大きいほど画像の生成速度が遅くなる。 |

| Batch Size | 生成する画像枚数。 |

| Batch Count | 一度に生成する画像の何枚。 |

| CFG Scale | プロンプトの影響の強さ。値が大きいほどプロンプトに忠実になるが、画像の品質が落ちることがある。 |

パラメータの調整後は、④の「Generate」を押して画像を生成しましょう。

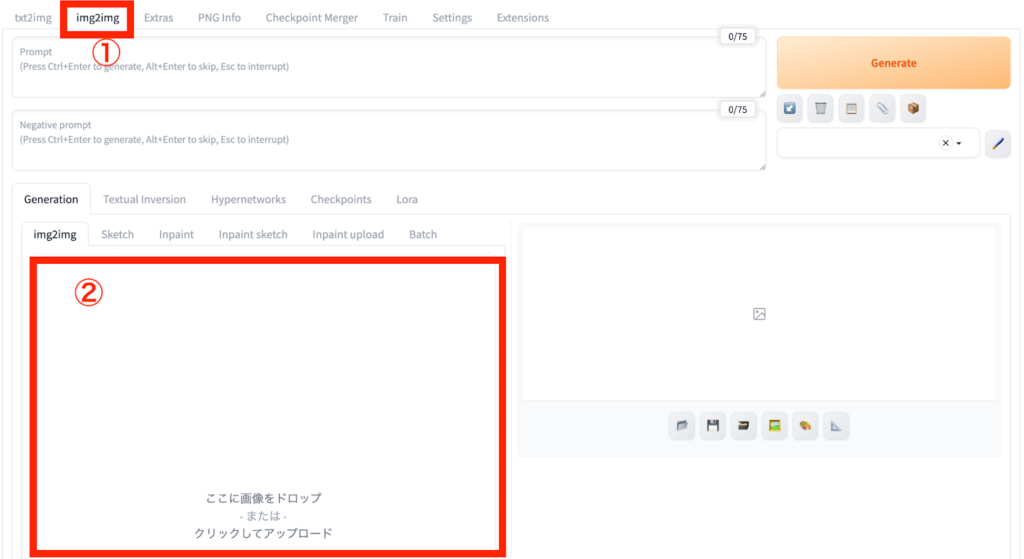

img2imgの使い方(画像から画像を生成)

画像入力で画像を生成したい場合は、上部①のimg2imgを選択して、その下にプロンプトを入力します。

②で画像をアップロードして、その下にある各種パラメータを調整しましょう。最後に「Generate」ボタンを押せば画像生成が始まります。

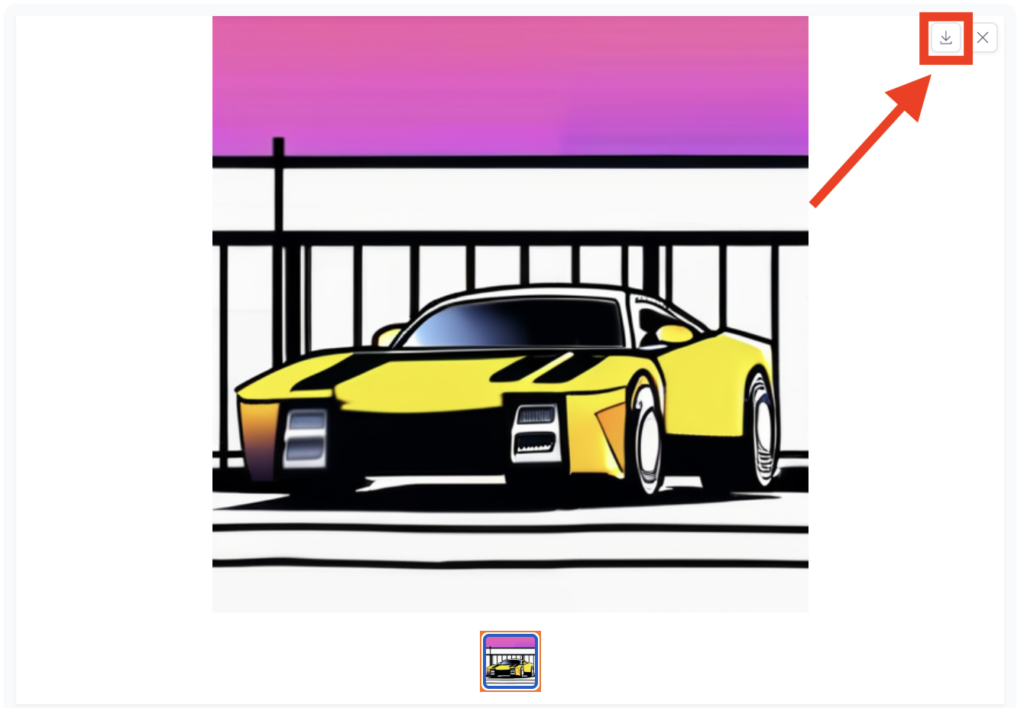

生成した画像の保存方法

生成した画像は、画像の右横にあるダウンロードボタンを押すことで保存できます。ボタンを押すだけでダウンロードが始まるので、複雑な工程はありません。

生成した画像を気に入った場合は、忘れずに保存しましょう。

よくあるトラブルと解決方法

Stable Diffusion Web UIを使用する中で、初心者から上級者まで直面しやすいトラブルがあります。ここでは代表的な3つの問題と、その対処法を紹介します。

真っ黒な画像が出る

画像が真っ黒になるトラブルは、プロンプトや設定の影響で生成がうまく行われていないケースが考えられます。ネガティブプロンプトが強すぎたり、ステップ数やCFGスケールの設定が極端だったりすると、正しく画像が描画されないことがあります。

まずはプロンプトをシンプルな内容に変えたり、ステップ数を20〜30、CFGスケールを7〜10程度に調整したりしましょう。また、使用しているモデルやSampler(例:DPM++系、Eulerなど)によっても結果が変わるため、設定を見直すことで改善が見込めます。

モデルが認識されない

モデルが表示されない、あるいは読み込まれない場合は、モデルファイルの保存場所に問題があるでしょう。基本的には 「models/Stable-diffusion 」フォルダ内に、「.ckpt」 または 「.safetensors」 ファイルを配置する必要があります。

また、ファイル名に全角文字や記号、日本語が含まれていると正常に読み込まれないことがあるため、英数字のみのファイル名に変更して再起動を試してみてください。

メモリ不足の対処法

VRAMが少ないPC環境では、画像生成中にエラーが発生することがあります。このような場合は、起動時に「–medvram」や「–lowvram」オプションを付けることで、VRAMの使用量を抑えることが可能です。

他にも、生成サイズ(解像度)を下げたり、不要な拡張機能(ControlNetなど)を無効にすることで、メモリ負荷を軽減できます。特にVRAMが6GB以下の場合は、モデル自体を軽量なものに切り替えるのも有効です。

Stable Diffusion Web UIを使って画像を生成してみた

ここからは、実際にStable Diffusion Web UIを使って画像を生成してみます。

まずは、こちらのプロンプトを入力してみました。

東京のオフィス街を歩くスーツ姿の若い女性

プロンプトを入力したあとは、「Generate」を押して画像が生成されるのを待ちます。

実際に生成された画像がこちらです。

顔の部分が潰れてしまっていて、あまりいい画像とはいえませんね。

次は、同じプロンプトを英語で入れてみました。

顔が若干ぼやけているように見えますが、さっきよりはプロンプトの再現度が上がっています。

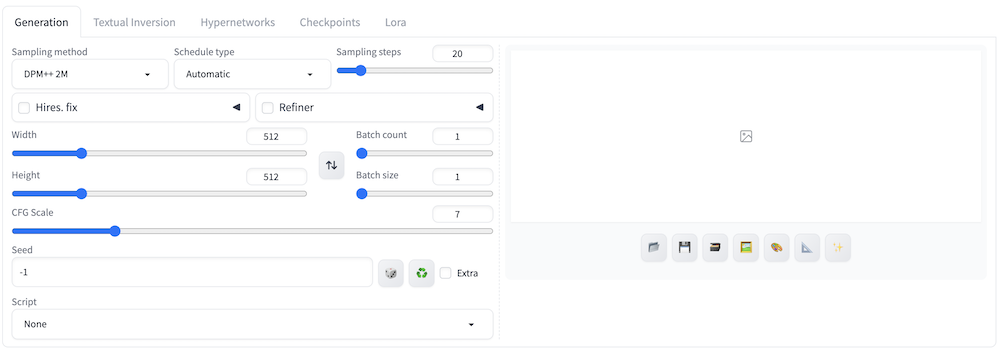

ちなみに、Stable Diffusion Web UIにはさまざまなパラーメーターがあるので、これらをいじると生成される画像の結果も変化します。

おもなパラメーターをまとめました。

- Sampling method:ノイズの除去方法。変えると生成画像の結果にも影響が出る。

- Width・Height:画像サイズの調整

- Sampling steps:ノイズを除去する回数で、多いと高品質になるが生成時間が長くなる。20〜30程度がおすすめ。

- CFG Scale:プロンプト従う影響度を調整できる。7〜12程度がおすすめ。

- Hires.fix:使用すると画像が高解像度・高品質になる。

- Batch count:1度に何枚の画像を生成するか指定できる。

- Batch size:一度に大量の画像を生成するための機能。例えば「2」に設定すると、Batch countの値×2倍の画像を生成できる。

上記のパラメーターのうち、「Hires. fix」にチェックを入れ、「CFG Scale」は10にしてみました。同じプロンプトで再度画像生成してみます。

実際に生成された画像が上記ですが、顔の部分以外は確かに質が向上しました。着ているスーツや背景の再現度が向上しているように感じます。

ただし、「Hires. fix」にチェックを入れた影響か、画像生成の時間もかなり長くなったので注意が必要です。

次は、アニメスタイルの画像生成をしてみます。

今回は以下のプロンプトを入れてみました。

Beautiful green-haired girl elf living in the forest, anime style.

(森に住む緑髪のエルフをアニメスタイルで)生成された画像がこちらです。

ゲームに出てきそうなレベルのクオリティになりましたね!

このようにプロンプトやパラメーターをいじるだけで、生成される画像の質が大きく変わってくるので、自身でいろいろ設定をいじりながら試してみてください。

Stable Diffusion Web UIを日本語化する方法

Stable Diffusion Web UIは、デフォルト設定で英語表記になっていますが、日本語化が可能です。日本語化する際は、以下の手順に従ってください。

- txt2imgの行の一番右にある[Extension]タブを開く

- [Available]タブを開く

- [localization]タブからチェックを外す

- [Load form]ボタンをクリックする

Stable Diffusion Web UIを日本語化する方法について詳しく知りたい方は、画像付きで解説している以下の記事を参考にしてみてください。

Stable Diffusion Web UIの拡張機能について

拡張機能の代表例としては、ControlNet・LoRA・Checkpointなどがあります。

| 拡張機能 | できること / 役割 | 向いている用途 |

|---|---|---|

| ControlNet | 画像のポーズ・輪郭・構図など“形”を正確に指定できる | 写真のポーズ再現、トレース、構図固定、実写寄りの制御 |

| LoRA | 少ない計算量で、特定の画風・キャラの特徴を強く反映できる | アニメ調、美少女系、人物の特徴付け、特定作風の再現 |

| Checkpoint(モデル本体) | 画像生成全体の“スタイル”を決めるベースモデル | 写実/アニメ/イラストなど作品の方向性選び |

それぞれの特徴や導入方法について詳しく知りたい方は、以下の記事も併せてご覧ください。

Stable Diffusion Web UIを利用する際の注意点

無料で高品質な画像を生成できるStable Diffusion Web UIですが、利用する際は以下の点に注意が必要です。

| 注意点 | 内容 | 補足説明 |

|---|---|---|

| 導入するまでにハードルがある | コマンド入力やライブラリのインストールが必要で、初心者には難しく感じやすい | エラーも出やすいが、導入手順やChatGPTを活用すればほとんど解決可能 |

| 希望の画像を出すにはプロンプト知識が必要 | 思い描く画像を生成するには、プロンプト(指示文)の書き方を理解する必要がある | ネット上に事例やテンプレが多いため、調べることで習得しやすい |

| 商用利用・著作権などライセンスに注意 | 生成画像の商用可否はモデルごとのライセンスに依存する | CreativeML OpenRAIL-Mなどを確認し、プライバシー侵害や不適切利用は不可 |

特に、導入するまでにさまざまなコマンドを実行して必要なライブラリをインストールする必要があるので、ITに詳しくない方からするとかなりハードルは高いです。

以下で注意点を詳しく解説するので、ぜひ参考にしてみてください。

導入するまでにハードルがある

Stable Diffusion Web UIの導入方法で解説していますが、Stable Diffusion Web UIを導入する際は、いくつかのコマンドを入力して必要なライブラリなどをインストールする必要があります。

この作業が順調に進まず、エラーが出ることも多々あるので、ITに詳しくない人からするとかなりハードルが高いです。

ただ、すでにStable Diffusion Web UIの導入方法やエラーへの対応については、当記事の内容などを参照いただければ、おおよそは解決できます。

エラーの原因がわからない場合は、ChatGPTに聞くと意外とすぐに解決できることもあるので、ぜひ活用してみてください。

希望の画像を出すためにプロンプトに関する知識が必要

自分が希望する画像を出力するためには、プロンプトに関する知識が必要です。生成AIを初めて利用する方にとっては、難しいと感じるかもしれません。

ただ、現在は多くの人はStable Diffusion Web UIを利用しているので、インターネットで検索すれば、有効なプロンプトはすぐに調べられます。

商用利用や著作権などのライセンスに注意する

Stable Diffusion Web UIで作成した画像は基本的に商用可否はモデルのライセンスで異なるため、各モデルのCreativeML OpenRAIL-M等の確認が必要です。また、他人のプライバシーを侵害する内容や人に危害を加えるような目的での使用は認められていません。

CivitaiやHugging Faceでモデルをダウンロードする際も、個別に商用利用の可否などが設定されているので、ダウンロード前に確認しておきましょう。

\画像生成AIを商用利用する際はライセンスを確認しましょう/

他の画像生成AIとの比較

Stable Diffusion Web UI以外にも、画像生成AIにはさまざまなツールが存在します。その中でも特に代表的なのが「Midjourney」や「DALL·E」などです。ここでは、それぞれの特徴とStable Diffusion Web UIとの違いを比較します。

Midjourneyとの違い

Midjourneyは、Discord上で操作するスタイルが特徴の画像生成AIです。プロンプトを入力するだけで美しく仕上がった画像を素早く出力できるため、操作の手軽さやデザイン性の高さが評価されています。しかし、細かなカスタマイズやモデルの切り替えはできません。

Stable Diffusion Web UIは、自分のローカル環境に構築することで、モデルや拡張機能を自由に追加できるのが大きな強みです。構図やスタイルの細かい調整が可能で、より自分好みに作り込みたい場合に適しています。

DALL·Eとの違い

DALL·EはOpenAIが提供する画像生成AIで、特にテキストからの画像生成精度が評価されています。2024年以降は「inpainting(画像の一部だけを修正)」機能も強化されており、編集用途にも活用されています。ただし、無料プランには使用制限があり、大量に生成する場合は有料プランへの加入が必要です。

Stable Diffusion Web UIはローカルで動作するため、インターネット環境に依存せず、使用回数の制限もありません。商用利用や大量生成を行う場合でも、コストを抑えながら運用できるのが利点です。

比較表

| 項目 | Stable Diffusion Web UI | Midjourney | DALL·E |

|---|---|---|---|

| 操作方法 | ローカルUI | Discordコマンド | Web UI |

| カスタマイズ性 | 高い(モデルや拡張も追加可) | 低め | やや低め |

| 生成スピード | やや遅め(スペック依存) | 速い | 速い |

| 無料範囲 | 完全無料(ローカル運用) | 有料(月額制) | 回数制限あり |

| 商用利用 | 可(モデルによる) | 可(一部条件付き) | 可(利用規約あり) |

それぞれのツールには得意・不得意があり、目的に応じて使い分けることで、より効率的に理想の画像を生成することができます。

Stable Diffusion Web UIの活用事例

Stable Diffusion Web UIは、個人利用だけでなく、企業による活用も広がりつつあります。特に、商品企画やプロモーションの分野では、画像生成AIの柔軟性や表現力を活かした事例が増加しました。ここでは、実際にWeb UIを活用した企業の取り組みを紹介します。

アサヒビール:プロモーション施策への応用

2023年9月26日、アサヒビールは新商品「アサヒスーパードライ ドライクリスタル」のブランドサイトにて、画像生成AI「Stable Diffusion」を活用した体験型プロモーション施策 「Create Your DRY CRYSTAL ART」 を日本で初めて展開しました。※1

このサービスでは、ユーザーが自身の写真とテキスト(例:「こんなとき輝いている」など)を入力すると、水彩画風やアニメ風などのスタイルを指定して、オリジナルアート作品を生成することができます。満20歳以上であれば誰でも無料で利用可能で、スマートフォンからLINE連携でアクセス可能です。

このプロジェクトは、Stable Diffusionを活用した大規模かつ消費者参加型のプロモーションとして初の事例であり、ブランドの世界観を体験として届ける新しい試みとして注目されました。

株式会社レベルファイブ:ゲーム開発での活用

ゲーム開発を手がけるレベルファイブは、制作初期の案出し工程にStable Diffusionを活用しています。※5

ゲームタイトル画面のレイアウト案、背景美術のラフ、3Dマップの室内案など、複数のバリエーションを短時間で生成し、デザイナーの発想支援に利用しています。最終的なブラッシュアップは人が行うものの、AIによって初期アイデアの幅を大きく広げられる点が評価されています。

セブン‑イレブン:商品企画のスピード化と効率化

セブンーイレブン・ジャパンは、2024年春から生成AIを商品企画プロセスに実験導入し、その後本格運用を開始しました。※6

これは、OpenAIやStability AIと連携して構築されたクラウドベースのAIシステムを活用し、販売データやSNS上の消費者の声をリアルタイムに分析する仕組みです。

この取り組みにより、商品コンセプトの文章や広告イメージ案をAIが自動生成し、従来の企画期間を最大で90%短縮できると報じられています。さらに、このAI活用は管理職層から導入が始まり、2024年春以降には一般社員への展開がされました。商品企画の初期段階だけでなく、パッケージデザイン案やPOP広告のイメージ生成にもAIを活用して、社内の作業工数やコストの削減、マーケティングのスピード向上に貢献しています。

海外事例:RunpodによるStable Diffusion Web UIクラウド提供

クラウドGPUサービスのRunpodでは、Stable Diffusion Web UI(v10.2.1)をワンクリックで起動できる専用テンプレートが公開されています。ユーザーはローカル環境のセットアップやライブラリのインストールを行う必要がなく、ブラウザ上からすぐに画像生成を始められる点が特徴。

レンタルできるGPUはRTX 3090など高性能モデルも選択でき、手元のPCスペックに依存せず高品質な生成が可能です。また、ControlNet・LoRA・DreamBoothなど主要な拡張機能に対応しているため、商用レベルの制作にもそのまま活用できます。生成した画像の保存やストレージの永続化、さらにAPI化によるサービス組み込みまでサポートしており、個人クリエイターから企業利用まで幅広い用途で利用が広がっています。

Stable Diffusion Web UIでよくある質問

Stable Diffusion Web UIでよくある質問をまとめました。

Stable Diffusion Web UIで画像を生成してみよう!

Stable Diffusion Web UIは、Webブラウザ上で手軽に画像を生成できる便利なアプリです。利用することで、以下のメリットを受けられます。

【Stable Diffusion Web UIを利用するメリット】

- 無料で利用できる

- カスタマイズが可能

- オフラインでも利用可能

ただし、導入する際の工程が多く、ハードルは少々高めです。

本記事でも導入方法を画像付きで詳しく解説しているので、ぜひ参考にしてみてください。

最後に

いかがだったでしょうか?

「Stable Diffusion Web UI」は、自由度の高い画像生成を可能にし、クリエイティブな業務を効率化します。この技術をビジネスにどう活用できるか、可能性を模索してみてください。

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。

- ※1:https://github.com/AUTOMATIC1111/stable-diffusion-webui?utm_source=chatgpt.com

- ※2:https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Installation-on-Apple-Silicon?utm_source=chatgpt.com

- ※3:https://github.com/lllyasviel/stable-diffusion-webui-forge?utm_source=chatgpt.com

- ※4:https://www.asahibeer.co.jp/news/2023/0926.html

- ※5:https://www.kantei.go.jp/jp/singi/titeki2/ai_kentoukai/gijisidai/dai4/siryou1.pdf

- ※6:https://sustainability.sej.co.jp/news/000690/?utm_source=chatgpt.com