- 生成AIには著作権侵害や誤情報の使用といったリスクがある

- 実際にOpenAIとMetaなどが著作権侵害で訴えられた事例が存在する

- 生成を導入する際はリスクの周知と運用ルールの徹底が大切

生成AIの利用には開発リスクやセキュリティリスクなど、さまざまなリスクがあります。トラブルが起きないよう適切な分析と対策が重要です。

アメリカでは、2023年の1月から7月までにOpenAIやMicrosoftなどのビッグテックを対象とした訴訟が起きています。訴訟されている理由は、同意や対価なしに著書や個人情報をAIに学習させているからです。※1

このようなトラブルは、日常的に生成AIを使用する私たちにも深く関係のある問題です。なぜなら、生成AIリスクを知らずに使用していると、知らずに著作権やプライバシーを侵害してしまう可能性があるからです。

この記事では、生成AIを使用する際のリスクやその対策方法と、生成AIを悪用した問題事例をわかりやすく紹介します。

最後まで読んだ方は、生成AIのリスクと注意点がわかり、対策しなければどのようなトラブルが起きるかを理解できます。

\生成AIを活用して業務プロセスを自動化/

生成AIのリスクを知るべき理由

生成AIは業務効率化や生産性向上に大きく貢献する一方で、適切に運用しないと企業に重大な損失をもたらす可能性があります。

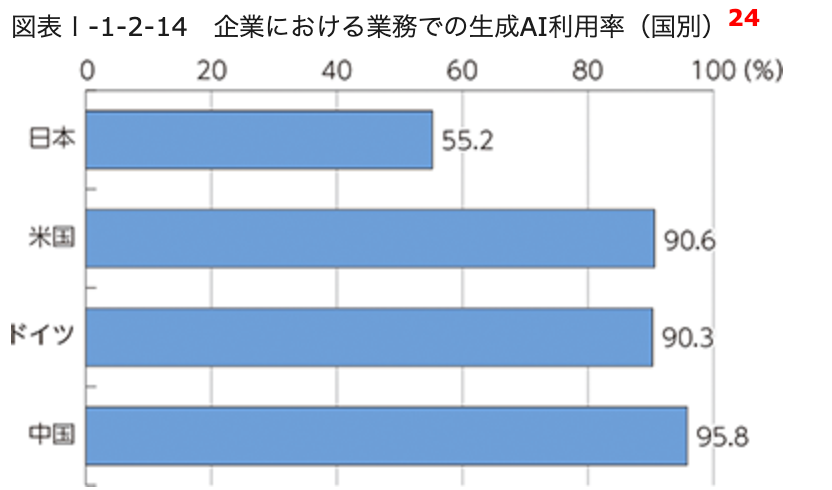

総務省の情報通信白書によれば、日本企業の生成AI利用率は2024年時点で55.2%に達しており、2023年の42.7%から増加しています。※2

しかし、急速に普及が進む反面、多くの現場ではリスク理解や対策が十分とは言えません。ここでは、生成AIの活用が進む今こそ知っておくべき「リスク理解の重要性」について、具体的な理由とともに解説します。

生成AIには大きなメリットがある反面で重大なデメリットも存在する

生成AIは業務の効率化や生産性向上、新たな価値創出など、企業にとって大きなメリットをもたらします。

文章作成やデータ整理、アイデア生成など幅広い場面で活用でき、従来の業務フローを大きく改善できる点は間違いありません。

しかし一方で、生成AIには明確なデメリットも存在します。生成AIのメリットとデメリットをそれぞれまとめました。

| 区分 | 内容 |

|---|---|

| メリット | ・業務効率化と生産性向上 ・新たな価値やアイデアの創出 ・創造性や発想力の向上 |

| デメリット | ・偏った情報の生成 ・ハルシネーションによる誤回答 ・悪意あるコンテンツの生成 |

法規制・社会的要求が強まり企業に対策が求められている

生成AIの普及に伴い、国内外で法規制やガイドライン整備が急速に進んでいます。EUでは包括的な規制となる「AI法」が本格施行され、リスクの高い生成AIには厳格なチェックを求める方針が示されました。※3

日本でも総務省の情報通信白書やデジタル庁の「生成AIガイドブック」が公開され、正確性の検証や個人情報の取り扱いなど、企業が守るべき実務上のポイントが明確化されています。※2※4

さらに、生成AIに関する問題点は学術研究でも多数指摘されています。2023年に発表された「Generative AI in Finance: Risks and Potential Solutions」では、金融分野における生成AIのリスクが論じられ、倫理的ガイドラインの策定などが提案されました。※5

社会的にも生成AIの安全性・透明性が求められている今、企業は法規制を踏まえた適切な運用ルールの整備が不可欠です。

なお、ChatGPTを企業利用におけるリスクについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

生成AIを使用する際のリスク・注意点

生成AIを導入することで業務改善ができるのになぜ、生成AIを導入していない企業があるのでしょうか?

その理由の一つとしてあげられるのは、生成AIを使うことで、著作権や商標権、機密情報の漏洩といったセキュリティ面における問題などさまざまなリスクが伴うからです。

事実、生成AIのリスクや注意点を知り対策しておかないと、知らぬ間に著作権や商標権、機密情報の漏洩をしてしまい訴訟問題になってしまいます。ここでは、生成AIのリスクや注意点についてわかりやすく紹介します。

著作権、商標権などの権利侵害

生成AIを使用する際には、著作権や商標権などの権利侵害に注意が必要です。

なぜなら、生成AIはインターネット上の膨大なデータを学習データとして使用するため、著作権や商標権で保護されたものも含まれる可能性があるからです。

その結果、生成AIによって作成されたコンテンツが、著作権や商標権などを侵害する可能性があります。

著作権や商標権を侵害してしまう例として、生成AIが学習データとして使用した画像やテキストが著作権で保護されている場合、そのAIによって生成されたコンテンツも著作権を侵害する可能性があります。

また、商標権で保護されたロゴや名称が生成AIによって無許可で使用された場合、商標権の侵害となってしまうこともあります。

ハルシネーションリスク

生成AIには、ハルシネーション(幻覚)と呼ばれる事実とは異なる情報を出力するリスクがあります。この現象は、学習データの偏りや不足、そして生成AIの内部構造の複雑さが原因です。

例えば、生成AIが学習したデータに存在しない情報や関連性を誤って生成する可能性があります。これはChatGPTなど高度な生成AIで見られる現象です。

したがって、生成AIを使用する際には、ハルシネーションリスクを理解し、適切なデータセットとモデル構造を選択することが重要です。

倫理的に不適切な情報の出力

生成AIの使用には、倫理的に不適切な情報の出力に注意が必要です。生成AIは機械学習によって訓練されますが、その学習データに偏見や不適切な内容が含まれている場合、生成AIもそれを反映した出力をする可能性があります。

一つの例として、生成AIが過去のニュース記事を学習した場合、その中に性差別や人種差別に関する偏見が含まれていれば、生成AIもそのような偏見を持つ文章や情報を生成する可能性があります。そのため、生成AIを使用する際には、その出力が倫理的に不適切な情報を含まないように、厳重な確認が必要です。

機密情報の漏洩

生成AIを使用する際には、機密情報の漏洩に特に注意が必要です。なぜなら、生成AIは大量のデータを学習して動作するため、その中に機密情報が混ざっていると、出力結果にもそれが反映される可能性があるからです。

例をあげると、企業内で生成AIを使ってレポートを作成する際、生成AIが学習したデータに社内の機密情報が含まれていた場合、そのレポートにも機密情報が含まれる可能性があります。

例外として、ユーザーのプライバシーとデータの安全性を保つために、ファインチューニングやエンべディングに使ったデータは、OpenAIの学習データには一般的には使用されないようになっています。

生成AIへの過度の信頼

生成AIは便利な機能ですが、その能力に過度の信頼をすることは非常に危険です。

なぜなら、生成AIはデータに基づいて動作するため、そのデータが不完全または偏っていると、出力も不正確になる可能性があるからです。また、生成AIは人間のような倫理観や判断力を持っていないため、その出力が常に正確であるとは限りません。

仮に、生成AIを使用して法的な契約書を作成する場合、AIが法的な誤りを含む文書を生成する可能性があります。このような場合、法的なトラブルに巻き込まれるリスクが高まります。

ディープフェイク

生成AIによるディープフェイクは、高度な技術でありながら、その誤用が社会的な問題を引き起こす可能性があります。

ディープフェイク技術は、生成AIが生成する非常にリアルな偽のビデオや画像を作成可能です。この技術が進化するにつれ、悪意を持って使用される場面も増えています。

具体的な例として、2022年3月にロシアがウクライナに侵攻した後ウクライナのゼレンスキー大統領が、ウクライナ国民に対し武器を捨てロシアに降伏するよう呼びかけている偽動画がYouTubeやFacebookで拡散されました。これも、ディープフェイクによる動画です。このような事例から、ディープフェイクの脅威が高まっています。

生成AIを使用する際のリスクに対する対策

前述の通り、生成AIを使用する際にはさまざまなリスク・問題点が潜んでいます。しかし、それぞれのリスクに対しての対策方法を理解していれば、大きな問題に発展する可能性を軽減できます。

次に、生成AIを使用する際のリスクに対しての対策について見てみましょう。

著作権や商標権などの権利侵害を起こさないための対策

著作権や商標権などの権利侵害を起こさないための対策は、生成AIが生成するために使用したデータの確認やコンテンツの内容の確認が必要です。

簡単にコンテンツ生成に使用したデータを確認できるようにするために、生成AIにデータの引用元を明記させましょう。引用元を明記させることでデータの確認が容易にでき、著作権や商標権侵害のリスク低減ができます。

ハルシネーションリスクへの対策法

ハルシネーションリスクを防ぐための対策として、「グラウディング」が有効です。これは、生成AIが指定された情報源だけに基づいて回答を生成する方法になります。

具体的な方法として、信頼できる情報源と照らし合わせ、情報が一致しているかどうかを確認しましょう。また、生成AIが使用するデータの品質や信頼性の検証も必要です。データが偏っていないか、誤った情報が含まれていないかを確認します。

そしてAIが生成した結果を検証し、正確性や妥当性を確認しましょう。結果が正しい情報かどうかを確認し、誤った情報や憶測が含まれていないかをチェックします。

またAIが生成する情報や結果の質を向上させるため、改善点の把握も重要です。生成AIは、自ら答えを探し学習する「ディープラーニング」を用いて構築されているため、正確な結果を出すためにも改善点の把握をしましょう。

このように、生成AIに情報源を指定することでハルシネーションを防ぐことができます。

倫理的に不適切な情報の出力をさせないための対策

生成AIを安全かつ倫理的に使用するためには、以下の3つの対策が効果的です。

- AIが学ぶ情報から偏見や不適切な内容を事前に除去する「データのクリーニング」

- AIが生成するテキストや画像に対して、不適切な言葉や表現をフィルタリングする機能を設ける

- AIの出力を定期的にチェックし、問題があれば修正する

以上の対策をすることで、生成AIが倫理的に不適切な情報を出力するリスクを最小限に抑えることが可能になります。

機密情報の漏洩への対策

機密情報の漏洩への対策は、オプトアウト設定がおすすめです。オプトアウト設定をすることで、ユーザーは自分の機密情報が不正にアクセスされたり、漏洩したりするリスクを大幅に減らすことができます。

例えば、ChatGPTのオプトアウト設定を有効にすることで、個人情報やビジネスに関する重要なデータが第三者に知られることなく安全にコミュニケーションを行うことができます。特に金融取引やビジネス戦略に関する情報を扱う際に有効です。

このように、ChatGPTのオプトアウト設定は機密情報の保護に不可欠な機能です。この設定をしっかりと管理することで、安全なコミュニケーションと情報保護が確保できます。

生成AIへの過度の信頼をしてしまうことへの対策

生成AIは、学習データやアルゴリズムの限界からくる誤りや偏見が起こる可能性があることを認識しておきましょう。

生成AIが生成したコンテンツは、必ずしも正確ではないため事実確認することが大切です。生成AIの出力は参考の一つとして活用し、他の信頼性の高い情報源も考慮することが重要です。

ディープフェイクへの対策

ディープフェイクには、検知ツールの使用やニュースソースの確認といった対策が有効です。それぞれの具体的な対策は以下の通りです。

| 対策内容 | 具体的な方法 |

|---|---|

| 自己学習コンテンツを活用する | Microsoftやワシントン大学、USA Today、Sensityが共同開発した自己学習コンテンツ「Spot the Deepfake」で、ディープフェイクを見破るポイントを学べます。 |

| 検知ツールを使用する | Microsoft、Sensity、Google、Metaなどが開発したディープフェイク検出ツールが存在します。しかし検知ツールを使用すれば安心という訳ではありません。 |

| ニュースソースを確認する | 一つの情報源だけで信用しないようにし、異なる方法で真偽を確認する習慣を身につけることが重要です。 |

ディープフェイクへの完全な解決策は、まだ確立されていません。十分に注意しましょう。

なお、生成AIを導入する際の社内ルールの決め方が気になる方は、以下の記事をご覧ください。

生成AIを開発する際のリスク・危険性

生成AIは、利用時だけではなく開発する際にも、さまざまなリスクや問題点があります。そのため、リスクと問題点を理解した上で、生成AIを開発することが重要です。

リスクや対策方法を知らずに生成AIを開発してしまうと、トラブルが起きる確率が格段に高くなります。もし、トラブルが起きてしまった場合、企業の信頼や社会全体に悪影響を及ぼしてしまうかもしれません。

生成AIは便利ですが、安全に正しく使用しないと法的な問題にも繋がる可能性があるので、生成AI開発時の体表的なリスクについて解説します。

プロンプトインジェクション

プロンプトインジェクションとは、ユーザーが悪意ある質問や指示を生成AIに送ることで、不適切な回答や情報漏洩を引き起こすリスクのことです。対話型AIであるChatGPTは、この種の攻撃に特に脆弱です。

例えば、ユーザーが他人の個人情報の開示を求めたり、違法な行為を助長するような指示を出すことがあります。この指示が成功すると個人情報が漏れるため、企業の信頼や社会全体に悪影響を及ぼす可能性があります。

モデルの盗用

モデルの盗用とは、開発したAIモデルが第三者によって無許可でコピーされ、商用目的や悪意ある活動で使用されることです。

どういうことかと言うと、自社で開発した文章生成AIが、競合他社によってコピーされ、そのままもしくは少しの改変で新しいサービスとしてリリースされるケースが考えられます。

過剰な代理行為

過剰な代理行為とは、生成AIが人間の意図や指示を過度に先読みして、不適切な行動を起こすことです。

例として、自動運転車の生成AIが過度に安全を確保しようとして、急停車を繰り返し、後続車に迷惑をかけるケースが考えられます。他にも、チャットボットがユーザーの質問に対して過度に詳細な個人情報を提供し、プライバシーを侵害する可能性がでてくるでしょう。

安全でないプラグイン設計

生成AIを開発する際、安全でないプラグイン設計は避けなければいけません。なぜなら、不完全なプラグインはデータ漏洩やシステム侵害の入り口になりやすいからです。

簡単に説明すると、プラグインが不適切なアクセス制限を持っている場合、外部からの不正アクセスが容易になり、機密情報が漏洩する可能性があります。また、プラグインが安全でないコードを含むと、それがシステム全体の脆弱性をひき起こす可能性があります。

サプライチェーンの脆弱性

生成AIのサプライチェーン脆弱性を防ぐためには、厳格なセキュリティプロトコルと継続的な監視が必要です。なぜなら、サプライチェーンにおける脆弱性は、外部からの攻撃や内部からのデータ漏洩につながる可能性があるからです。

仮に、生成AIが使用する外部のデータベースがセキュリティに問題があることで、そのデータベースから流出した情報が生成AIに組み込まれる可能性があります。また、生成AIの訓練に使用されるオープンソースライブラリが脆弱であれば、攻撃者によって悪用される危険度が高まります。

モデルのDoS

生成AIのモデルもDoS攻撃の対象になる可能性があり、対策を打つことが必要です。なぜなら、生成AIモデルは、多くのリソースと計算能力を必要とし、攻撃者が意図的に高度な計算を要求するクエリを送ると、サービスが遅延したり停止したりする可能性があるからです。

DoS攻撃とは、攻撃者が大量の複雑な質問や命令を生成AIに送り、その計算能力を極限まで使い果たすことで、他の正当なユーザーがサービスを利用できなくなる場合のことです。

訓練データの汚染

訓練データの汚染は、生成AIの性能と信頼性に重大な影響を与えます。なぜなら、生成AIは訓練データに基づいて学習するため、訓練データが不正確や偏見、または誤情報を含んでいる場合、生成AIの出力にも影響が出るからです。

例をあげると、健康に関する生成AIが、誤った医学情報を含む訓練データで学習した場合、その生成AIは不正確な医療アドバイスを提供する可能性があります。また、自動運転車の生成AIが不正確な交通ルールを学習した場合、交通事故のリスクが高まるでしょう。

生成AIの過学習と適応不足

生成AIを開発する際のリスクとして、過学習と適応不足があります。

過学習は、生成AIが訓練データに過剰に適応することで、新しいデータに対してうまく機能しなくなる現象です。一方適応不足は、生成AIが訓練データを十分に学習できておらず、予測力を持たない状態を指します。

これらの問題を避けるためには、適切な訓練データの選択やモデルの正則化、適切な学習率の設定といった対策が必要になります。

生成AIを開発する際のリスクに対する対策

このように、生成AIを開発するにはさまざまなリスクが存在し、具体的なリスクについては前章で理解していただけたかと思います。企業はこれらの問題点を慎重に分析し、適切な対策を講じる必要があります。

では、それらのリスクはどのように対応すればいいのでしょうか。ここからは生成を開発する際のリスクに対する対策について解説します。

プロンプトインジェクションへのリスク対策

プロンプトインジェクションはオンラインセキュリティの脅威の一つです。悪意のあるユーザーがアプリケーションのコマンドプロンプトに不正なコードを挿入し、システムに損害を与える手法です。この脅威に対処するためには、効果的なセキュリティ対策が必要になります。

対策として以下のようなことが考えられます。

- 既知の脆弱性を作り込まない

- ユーザーからの入力を検証

- ChatGPTで入力を検証

- ChatGPTからのレスポンスを検証

これらの対策を組み合わせることで、プロンプトインジェクション攻撃のリスクを大幅に低減可能です。

モデルの盗用へのリスク対策

生成AIにおけるモデルの盗用は、知的財産権の侵害やセキュリティの脆弱性といったリスクがあります。他者が生成したモデルを不正に入手し、それを自身の利益のために利用することは、個人や企業にとって大きな損害をもたらすでしょう。このようなリスクに対処するためには、セキュリティ対策や法的手段を講じる必要があります。

対策として、次のことが考えられます。

- アクセス制限

- 暗号化

- 透明性の低減

- 監視とログを保存

- 法的手段

これらの対策を適用することで、生成AIモデルの盗用を効果的に防ぎ企業の知的財産を守ることができます。

過剰な代理行為へのリスク対策

生成AIにより、人間の代わりにタスクをこなすことが一般的になりつつあります。しかし、過剰な代理行為が発生するリスクも存在します。

この過剰な代理行為を避けるためには、生成AIの行動範囲を明確に制限するとともに、人間の監視と介入が容易な設計にする必要があります。

- 機能制限

- ユーザーの確認

上記のような対策をすることで、過剰な代理行為を低減できます。

安全でないプラグイン設計にしないためのリスク対策

生成AIの使用に伴い安全性が重要視される中、不適切なプラグイン設計は重大なリスクとなります。この課題を克服するためには、安全なプラグイン設計の重要性を知り、適切なリスク管理と対策が必要です。

対策として以下のようなことが考えられます。

- コードレビュー

- ユーザー認証

- 最小限原則

- データの暗号化

- 自動アップデート

上記のような対策を適用することで、生成AIのプラグイン設計をより安全にし、ユーザーに安心して使用してもらえる環境を提供できます。

サプライチェーンの脆弱性へのリスク対策

生成AIにおけるサプライチェーンの脆弱性は、サイバー攻撃やデータの改ざんなどのリスクがあります。このリスクに対処するためには、サプライチェーンの見直しをし、またセキュリティを強化する必要があります。

対策としては以下のようなことが考えられます。

- コードの監査

- データ暗号化

- アクセス制限

以上の対策を実施することで、生成AIのサプライチェーンにおける脆弱性を最小限に抑え、より安全な環境を確保できます。

モデルのDoSへのリスク対策

生成AIは便利なツールですが、悪意のある攻撃者によるDoS(Denial of Service)攻撃の標的になる可能性があります。生成AIモデルがDoS攻撃に対してどの程度脆弱であるかを調査し、それに対処するための効果的な対策を検討しましょう。

モデルのDoSへの対策として、以下のようなことが考えられます。

- トラフィック監視

- レート制限

- 冗長性の確保

これらの対策をすることで、生成AIモデルに対するDoS攻撃のリスクを大幅に減らし、サービスの安定性を高めることができます。

訓練データの汚染へのリスク対策

生成AIは訓練データから学習してユーザーへ結果を表しますが、そのデータの質によって生成される結果が大きく影響されます。

訓練データに誤った情報が含まれていれば、その汚染されたデータを使用して、生成AIが誤った結果を生成するリスクが高まります。そのため、訓練データの汚染への対策が重要です。

対策としては、次のことが考えられます。

- データソースの確認

- 前処理とクレンジング

- データの検証

- バージョン管理

- 定期的な監査

以上の対策を適用することで、訓練データの汚染を効果的に防ぎ、AIモデルの性能と信頼性を高めることができます。

生成AIを悪用した問題事例4つ

生成AIを使った偽動画や音声による詐欺など、さまざまな犯罪が起きています。今までに起きている問題事例を知っておくことで、生成AIを企業利用する際のリスクを避けられるかもしれません。

ここでは、過去に実際に起きている生成AIを悪用した問題事例を紹介します。ぜひ、参考にしてください。

ディープフェイク音声による詐欺

英国のエネルギー企業のCEOが、上司であるドイツの親会社のCEOからと思われる電話を受け、緊急で22万ユーロ(約2600万円)をハンガリーのサプライヤーに送金するよう指示されました。しかし、この指示はAI音声技術を使った詐欺師からのものだったのです。

詐欺師は2回目の送金を要求する際に再度電話をかけましたが、その時、英国のCEOはオーストリアの番号からの電話であることに気づき、詐欺だと判明しました。

この事件は保険会社によって報告され、市販のAI音声生成ソフトが詐欺に使用されたとされています。この事件が起こったことにより、AI技術が詐欺にどれだけ容易に利用しやすいかを証明しています。※6

OpenAIとMetaに対する訴訟

米国で生成AIの開発企業に対する訴訟が増えています。主な原因は著作権やプライバシーの侵害です。

例えば、人気コメディアンで作家のサラ・シルバーマン氏は、自身の著書がAIの学習に無断で使用されたとして、OpenAIとMetaに対して集団訴訟を起こしています。※7

このような訴訟は、開発企業だけでなく一般企業にも起こりうる可能性があるため、生成AIの使用には十分注意する必要があります。

AIの画像生成能力を悪用した恐喝行為

生成AIの画像生成能力を使った「セクストーション」と呼ばれる犯罪が起きています。この犯罪は、AIの画像生成技術を使って、SNSや共有された一般的な写真を不適切な内容に変換し、被害者を脅迫するといったものです。

このセクストーション犯罪は、ディープフェイク技術を用いて普通の写真から不適切な画像や動画を生成します。SNSやポルノサイトに掲載し、被害者から身代金を要求するケースが急増しており、未成年も巻き込まれ問題となっています。※8

フィッシングメールによるサイバー攻撃

近年、フィッシングメールを利用したサイバー攻撃も増加しています。

フィッシングメールは個人情報を不正に取得し、詐欺や不正アクセスに利用されるため、注意が必要です。

海外のEメールセキュリティメーカーであるVadeの調査によると、2023 年第3四半期8月のフィッシング攻撃は同じく2023 年第3四半期の7月と比べて約2倍となる2億730万件以上の増加。2番目に多かったのは9月で、フィッシングメールの送信は1億7,260万件でした。※9

フィッシングメールは、大量に送られることが一般的です。攻撃者は何百万人にもメールを送り、その中の少しでも引っかかると、さらにサイバー攻撃を行うことができます。今後もフィッシングメールは増えると予想されます。

生成AIのリスクマネジメントの方法

では実際に、生成AIに対するリスクマネジメントをどのように進めていけば良いのでしょうか?特に重要なポイントを解説します。

企業における生成AIのリスクマネジメントのポイント

企業におけるリスクマネジメントのポイントは、内部リスクと外部リスクを分けて把握することが重要です。その理由は、リスクの性質や対策の方向性が異なるためです。

内部リスクは、企業が自社の運用や管理を改善することで、ある程度コントロールが可能です。一方、外部リスクは、企業の努力だけでは防ぎきれない場合があります。

そのため、内部リスクと外部リスクを分けて把握することで、それぞれのリスクに対する適切な分析とリスク対策を講じることができます。

生成AIの内部リスク

生成AIの内部リスクには、誤情報の使用や情報漏洩などがあります。その他の内部リスクも含めて、一覧をまとめました。

- 社員による誤入力(機密情報・個人情報の入力ミス)

- 誤情報(ハルシネーション)を業務にそのまま使用するリスク

- 出力内容の誤解・読み違いによる判断ミス

- 生成AIの回答を過信することで起こるチェック漏れ

- 社内ルール・ガイドラインの未整備による不適切運用

- 部署ごとの利用レベル差による運用のばらつき

- 権限管理・アクセス管理が不十分なことによる情報流出リスク

- 社内ナレッジや機密情報が意図せずモデル学習に利用されるリスク

- 従業員のリテラシー不足による操作ミス・誤用

内部リスクに対応するには、生成AIに対する理解を深める教育と、システム改善が不可欠です。

生成AIの外部リスク

外部リスクとは、企業の外部要因によって発生するリスクです。

- 生成AIの悪意のある目的での利用

- 脆弱性による攻撃

- 経済・ブランドイメージ・評判への影響

外部リスクに対する対策は難しいですが、セキュリティ対策の実施やリスクや対策を社員向けに共有するなどが有効です。状況に応じて適切なリスク分析と対策をしていきましょう。

なお、生成AIを導入する具体的なステップが知りたい方は、以下の記事をご覧ください。

生成AIのリスク対策についてよくある質問

生成AIを使用する上でのリスク対策についてよくある質問を下記にまとめました。

弊社の生成AIのリスクへの対応

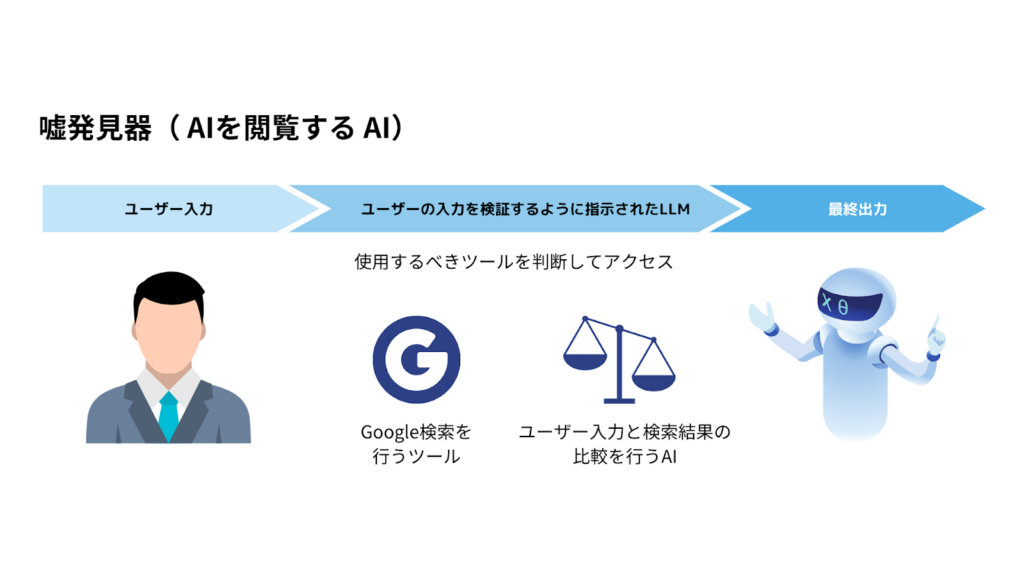

弊社では、ハルシネーション対策ができるAIの開発実績があります。

生成AIには、”ハルシネーション“という「嘘の情報を本当のことのように話す」振る舞いが問題視されています。

弊社では、様々な手法でこの問題の対処に取り組んでいますが、1つの手法として「AIを検閲するAI」の開発を行っています。

この例では、AIが生成した回答が正しいのかどうか、Google検索などで取得したデータソースにアクセスし、本当の情報であるかどうか検証しています。

他にも、論文データベースや自社の正しい情報のみが載っているデータにアクセスすることで、より高度な検閲機能の実装が可能です。

生成AIのリスクを理解しセキュリティ対策をしよう

生成AIは正しく使用すればとても便利ですが、生成AIにおける適切な分析とリスク対策を行わなければ社会問題にまでなってしまう可能性を秘めています。

まだまだ、生成AIは完ぺきではなく問題点もたくさんあります。企業で生成AIの利用を検討しているのであれば、生成AIで出来ることや気をつけること、セキュリティリスクを把握する必要があるでしょう。

さらに、社員への生成AIの企業利用におけるリスクについての研修実施や生成AIを利用する際のマニュアル・ガイドラインを充実させることで、セキュリティリスク対策に繋がるでしょう。

さまざまな企業で生成AI技術の開発が進み、生成AI技術は日々進化しています。しかし、進化していくことでリスクも大きくなっていることを十分理解し対策しましょう。

セキュリティ対策をすることで、企業の価値や社会的信頼を高めることが可能になります。

最後に

いかがだったでしょうか?

著作権や個人情報のリスクを回避しつつ、安全に生成AIを導入するための具体的な対策を、専門家の視点から整理してみませんか?

株式会社WEELは、自社・業務特化の効果が出るAIプロダクト開発が強みです!

開発実績として、

・新規事業室での「リサーチ」「分析」「事業計画検討」を70%自動化するAIエージェント

・社内お問い合わせの1次回答を自動化するRAG型のチャットボット

・過去事例や最新情報を加味して、10秒で記事のたたき台を作成できるAIプロダクト

・お客様からのメール対応の工数を80%削減したAIメール

・サーバーやAI PCを活用したオンプレでの生成AI活用

・生徒の感情や学習状況を踏まえ、勉強をアシストするAIアシスタント

などの開発実績がございます。

生成AIを活用したプロダクト開発の支援内容は、以下のページでも詳しくご覧いただけます。 ︎株式会社WEELのサービスを詳しく見る。

︎株式会社WEELのサービスを詳しく見る。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。 ︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、サービス紹介資料もご用意しておりますので、併せてご確認ください。

- ※1:OpenAIやMicrosoftなどのビッグテックを対象とした訴訟問題について

- ※2:総務省「情報通信白書」(第Ⅰ部 特集 広がりゆく「社会基盤」としてのデジタル)

- ※3:EUのAI法について教えてください

- ※4:テキスト生成AI利活用におけるリスクへの対策ガイドブック(α版)|デジタル庁

- ※5:生成AIの問題点に関する論文

- ※6:AI版「オレオレ詐欺」で2500万円を送金、英企業が被害

- ※7:生成AIの著作物の利用は「フェアユース」に該当するか?

- ※8:海外EメールセキュリティメーカーVadeによるサイバー攻撃調査報告

- ※9:AIの画像生成能力を悪用した恐喝行為、”セクストーション”が増加傾向に。FBIが警告

- ※10:総務省「情報通信白書」(第Ⅱ部 情報通信分野の現状と課題)

【監修者】田村 洋樹

株式会社WEELの代表取締役として、AI導入支援や生成AIを活用した業務改革を中心に、アドバイザリー・プロジェクトマネジメント・講演活動など多面的な立場で企業を支援している。

これまでに累計25社以上のAIアドバイザリーを担当し、企業向けセミナーや大学講義を通じて、のべ10,000人を超える受講者に対して実践的な知見を提供。上場企業や国立大学などでの登壇実績も多く、日本HP主催「HP Future Ready AI Conference 2024」や、インテル主催「Intel Connection Japan 2024」など、業界を代表するカンファレンスにも登壇している。